C++杂记 - 3

std::bind, std::function 和 std::mem_fn

std::bind 包括但不限于mem_fn的功能,更为通用的解决方案

什么是bind?我们可以把它看作一个通用的函数适配器,它接受一个可调用对象,生成一个新的可调用对象来“适应”原对象的参数列表。

std::bind将可调用对象与其参数一起进行绑定,绑定后的结果可以使用std::function保存。std::bind主要有以下两个作用:

- 将可调用对象和其参数绑定成一个仿函数;

- 只绑定部分参数,减少可调用对象传入的参数。

语法:

1

auto newCallable = bind(callable, arg_list);

该形式表达的意思是:当调用newCallable时,会调用callable,并传给它arg_list中的参数。

需要注意的是:arg_list中的参数可能包含形如_n的名字。其中n是一个整数,这些参数是占位符,表示newCallable的参数,它们占据了传递给newCallable的参数的位置。数值n表示生成的可调用对象中参数的位置:_1为newCallable的第一个待填充参数,_2为第二个待填充参数,以此类推。 注意这些占位符在std::placeholders名称空间内。

std::bind的返回值是可调用实体,可以直接赋给std::function。

bind绑定类非静态成员函数时,第一个参数表示对象的成员函数的指针,第二个参数表示对象的地址,这是因为对象的成员函数需要有this指针。并且编译器不会将对象的成员函数隐式转换成函数指针,需要通过&手动转换(符合成员函数指针的赋值语法)。静态成员函数无需此操作。因为没有this指针。

注意传入对象地址也可以传入对象的引用或对象本身。

在类内使用该类的成员函数的时候,和类外使用一样。都需要取地址并且传入对象指针。只不过可以使用

this替代。这个的常见案例是类内含有

thread的时候,比如这种情况:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17

struct test{ test():th1(bind(&test::threadfunc, this)){}; //因为是类内使用该类成员函数,所以需要绑定,但是可以使用this替代。 ~test(){ if(th1.joinable()){ th1.join(); } } private: void threadfunc(){ //成员函数。 cout <<"hello world" << endl; } thread th1; }; int main(){ test mytest; }

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

class my_class{

public:

int val;

my_class(int x):val(x){}

void getval(){

cout << val << endl;

}

void add(int another){

val = val + another;

cout << val << endl;

}

static void staticfunc(int val){

cout << "static" << val << endl;

}

};

int main(){

my_class obj1(10);

auto task2 = bind(&my_class::getval, &obj1); //调用无参函数,this参数预绑定。成员函数指针遵循语法。

auto task3 = bind(&my_class::add, &obj1, placeholders::_1); //调用有参函数,this参数预绑定。

auto task4 = bind(&my_class::add, placeholders::_1, placeholders::_2); //调用有参函数,this参数使用占位形式。

auto task5 = bind(&my_class::staticfunc, placeholders::_1); //静态成员函数没有this指针。无需传入。

task2();

task3(3);

task4(&obj1, 3); //this使用占位形式,需要调用时传入。

task5(3);

return 0;

}

- 默认情况下,bind的那些不是占位符的参数会被拷贝或移动(以值传递)到bind返回的可调用对象中。如果需要使用引用传递,必须使用

ref

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

void mypred(int a, int b, vector<int>& c){ 尽管这里函数头使用了引用,但是bind在预绑定的时候(也就是非placeholder参数)默认会拷贝一份原参数进行传入,也就是默认是值传递。所以这里的容器c其实是一个局部变量。

if(a < b){

cout <<"yes" << endl;

c.push_back(a);

}

}

int main(){

vector<int> test = {1};

vector<int> final;

final.reserve(10);

for_each(test.begin(), test.end(), bind(mypred, placeholders::_1, 3, ref(final))); 所以这里我们如果要使用引用来传递final,则必须要使用ref函数来获取其引用。

for(auto i = final.begin(); i != final.end(); i++){

cout << *i << endl;

}

return 0;

}

使用std::bind搭配priority_queue 和 vector的自定义排序。

请参考STL-1笔记

慎用std::bind, 如果可能的话使用lambda

https://lefticus.gitbooks.io/cpp-best-practices/content/08-Considering_Performance.html

https://stackoverflow.com/questions/49246242/efficiency-of-stdbind-vs-lambda

https://youtu.be/ZlHi8txU4aQ

https://mp.weixin.qq.com/s/VOqPjW48DG3gp60EqkYrTQ

mem_fn 成员函数适配器 把成员函数转为函数对象,使用对象指针或对象(引用)进行绑定

个人实验得出的结论:mem_fn是bind的子集。

注意mem_fn不能调用类静态成员函数。因为没有this指针。

mem_fn就是强制给你把类对象塞进去。

mem_fn无法接受额外参数。也就是无法使用placeholder

mem_fn的核心功能是把类成员函数转换成不需要类成员就可以调用的形式。就是把this指针绑定到类成员函数的隐藏this参数上。但是调用的时候依旧需要传入一个对象地址。。就很废物。

比较:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

class my_class{

public:

int val;

my_class(int x):val(x){}

void getval(){

cout << val << endl;

}

void add(int another){

val = val + another;

cout << val << endl;

}

static void staticfunc(int val){

cout << "static" << val << endl;

}

};

int main(){

my_class obj1(10);

auto task1 = mem_fn(&my_class::getval);

task1(&obj1); //把对象地址传入

auto task2 = mem_fn(&my_class::add);

task2(&obj1, 5);

//auto task3 = mem_fn(&my_class::staticfunc); 错误!静态成员函数不行。

auto task1_1 = bind(&my_class::getval, placeholders::_1); //bind就得多写个参数

task1_1(&obj1);

auto task1_2 = bind(&my_class::getval, &obj1);

task1_2();

return 0;

}

std::placeholders

我们提到了,我们使用bind的时候,placeholder是待填充参数。什么叫待填充?这是一种具象解释。其实bind相当于生成了一个新的可调用对象,拥有两个参数。但是结合原本的可调用对象来看,我们有三个参数。所以站在原本的可调用对象角度来看,这原来的可调用对象中多出来的一个参数相当于已填充参数。剩下的两个参数相当于待填充。

语法和例子:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

void testfunc(int x, int y, int z){

cout << x << endl;

cout << y << endl;

cout << z << endl;

}

int main(){

auto callable1 = bind(testfunc, placeholders::_1, placeholders::_2, 5);

callable1(8,80);

//输出8 80 5

auto callable2 = bind(testfunc, placeholders::_2, placeholders::_1, 5);

callable2(8,80);

//输出80 8 5

auto callable3 = bind(testfunc, placeholders::_1, 5, placeholders::_2);

callable3(8,80);

//输出8 5 80

auto callable4 = bind(testfunc, placeholders::_1, 5, placeholders::_3); //错误。新的调用对象只有两个参数。这里3超了。并placeholders且必须按序。不可跨越。不能没有2的时候直接使用3,尽管可能待填充参数一共有3个。

callable4(8,80);

auto callable5 = bind(testfunc, placeholders::_1, 5, placeholders::_1); //极端情况。占位符可以重复。

callable5(8);

//输出8 5 8

}

注意

placeholder编号必须按序。此处按序指的是不能没有2的时候直接使用3- 并且编号不能大于待填充参数的数量。

参考资料:https://elloop.github.io/c++/2015-12-15/learning-using-stl-12-std-bind

std::function

大家都用过函数指针。具体就不赘述了。稍微回忆一下函数指针的语法:

1

2

void(*another_a_ptr_ptr)(void) = (void(*)(void))*(long long*)(*a_ptr);

void(*another_a_ptr_ptr)(void); 这个函数指针的类型是void(*)(void)

成员函数指针的用法和声明在杂记2。

std::function是一个多态可调用对象包装器,是一个类模板,可以容纳除所有可调用对象(类成员函数和指针需要bind一下),它可以用统一的方式处理函数、函数对象、函数指针,lambda并允许保存和延迟它们的执行。基本上任何有函数调用运算符重载operator()的对象都可以被function包装。

注意,std::function支持多态。

一个例子让你知道function怎么用:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

int myfunc(int a){

cout << a << endl;

return a;

}

int myfunc1(const int& a){

cout << a << endl;

return a;

}

int myfunc2(int&& a){

cout << a << endl;

return a;

}

int main(){

function<int(int)> func = myfunc;

func(4);

function<int(const int&)> func1 = myfunc1;

func1(4);

function<int(int&&)> func2 = myfunc2;

func1(4);

return 0;

}

说白了就是类型是你的函数返回值类型+参数类型。

因为std::function可以保存lambda。所以当函数签名的参数是std::function对象的时候,可以直接传入一个类型匹配的lambda对象。有隐式类型转换

我们前面提到过 bind的返回值是可调用实体,可以直接赋给std::function

1

2

3

4

5

function<void(void)> task1_2 = bind(&my_class::getval, &obj1);

task1_2();

function<void(int)> task2 = bind(&my_class::add, &obj1, placeholders::_1);

task2(5);

有一个问题是,这里必须要显式把对象地址直接塞进去,不能把对象地址用占位符。因为参数对不上了。(个人实验)

故而,std::function的作用可以归结于:

- std::function对C++中各种可调用实体(普通函数、Lambda表达式、函数指针、以及其它函数对象等)的封装,形成一个新的可调用的std::function对象,简化调用;

- std::function对象是对C++中现有的可调用实体的一种类型安全的包裹(如:函数指针这类可调用实体,是类型不安全的)。

慎用std::function 性能极差

虚函数的开销是常规函数的5倍,std::function是6倍以上。

原因是std::function的底层还是使用虚函数,进行多态调用。因为使用了类型擦除。同时,std::function是通用的,并且它不知道包装的可调用对象多大(比如lambda就是动态大小的,我们在lambda一节中提到了lambda的大小取决于捕获参数的数量和方式)。但是可调用对象必须要被std::function所保存,这样才能在std::function对象被移动或复制的时候正确的移动或复制。它的内部有一个缓冲区。如果可调用对象足够小,则不需要新开内存。所以当可调用对象大于某个阈值的时候,它需要使用动态内存分配来存储。同时,有几种方法可能避免。比如使用std::ref包装参数,或者在使用lambda函数初始化std::function对象时,对应的lambda可以使用引用捕获参数避免lambda的大小膨胀。

https://wizmann.tk/cpp-type-erasure-and-std-function.html

https://stackoverflow.com/questions/5057382/what-is-the-performance-overhead-of-stdfunction

https://stackoverflow.com/questions/18453145/how-is-stdfunction-implemented

https://blog.demofox.org/2015/02/25/avoiding-the-performance-hazzards-of-stdfunction/

关于std::function和多态

std::function既然叫做多态函数包装器,那么就可以正确处理多态。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

class father{

public:

father()= default;

virtual void func(){

cout <<"father" << endl;

}

};

class child:public father{

public:

child() = default;

void func(){

cout << "child" << endl;

}

};

int main(){

father* fptr = new child;

function<void(void)> funcobj = bind(&father::func, fptr);

funcobj(); //输出child

return 0;

}

关于源码解析

脸都看绿了。

https://blog.csdn.net/zdy0_2004/article/details/50652934

https://blog.csdn.net/weixin_43798887/article/details/116571325

https://zhuanlan.zhihu.com/p/560964284

https://zhuanlan.zhihu.com/p/66301236

在函数中传递std::function对象,搭配bind并考虑使用placeholders。

为了方便起见。此处仅使用全局函数为例。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

void test(int a, int b, const string& c){

cout << a << b << c << endl;

}

void funcinput(function<void(int, int, const string&)> in_func){//注意函数入参签名

in_func(1,2,"abc");

}

void another_funcinput(function<void(int, const string&)> in_func){ //注意函数入参签名

in_func(2,"abc");

}

int main(){

funcinput(bind(&test, placeholders::_1, placeholders::_2, placeholders::_3)); //输出12abc

another_funcinput(bind(&test, 1, placeholders::_1, placeholders::_2));//输出ab123

return 0;

}

我们打算将std::function对象传入函数。

注意在搭配bind使用的时候。注意function的类型。[下方例子全部忽略第一个实际参数(为函数地址)]。**`function`的类型为函数返回类型+除预先绑定的参数以外的全部参数类型(所有`placeholders`代表的类型)。**

- 在

bind(&test, placeholders::_1, placeholders::_2, placeholders::_3)的时候,由于三个参数全部为placeholders,所以此时function的类型为目标函数的返回值类型+全部参数类型。为function<void(int, int, const string&)>。 - 在

(bind(&test, 1, placeholders::_1, placeholders::_2)的时候,由于第一个参数为预绑定,只有两个placeholders,所以此时function的类型为目标函数的返回值类型+除第一个外,也就是剩余的参数类型。为function<void(int, const string&)>

一个稍微复杂的包裹类练习。使用了模板和bind

我们这一段代码的目的是想简单模拟一下unique_ptr调用自定义删除器的过程。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

class myInt{

public:

int val1;

myInt() = default; //要点1

myInt(int x):val1(x){}

void operator()(int a){ //要点2

cout << a <<endl;

cout <<"called" << endl;

}

};

void global_func(int x){

cout << x << endl;

cout <<"global" << endl;

}

template<typename T1, typename T2>

class anotherone{

public:

T1 callable; //要点3

T2 value;

anotherone() = default;

anotherone(T2 val):value(val){} //要点4

anotherone(T1 func, T2 val): callable(func), value(val){} //要点5

void operator()(){

callable(value);

}

};

int main()

{

myInt tests; //要点6

auto objbind = bind(&myInt::operator(), &tests, placeholders::_1); //要点7

typedef decltype(objbind) mytype; //要点8

anotherone<mytype, int> myobj2(objbind, 200); //要点9 T1是bind类型

anotherone<myInt, int> myobj(234); //要点10 T1 是 myInt类型

myobj2();

myobj();

anotherone<void(*)(int), int> myobj3(global_func, 345);

myobj3();

return 0;

}

- 要点1

myInt必须提供默认构造。原因是我们的anotherone在不接受函数对象做为可调用对象的时候,会利用第一个模板参数的类型构建一个 第一个模板参数类型的对象。也就是myInt对象。如果没有默认构造则会失败 - 要点2

operator()没有固定实现。返回值可以依靠不同需求做决定 - 要点3等同于要点1。在不接受函数对象做为可调用对象的时候,这个东西是第一个模板参数的类型的对象。然后我们会调用这个对象的

operator()来进行调用。如果是一个可调用对象,则利用这个可调用对象进行调用。比如bind和function或函数指针。 - 要点4是为了匹配不提供调用对象只提供类型的情况

- 要点5是为了匹配提供调用对象的情况

- 要点6和要点7是bind成员函数的时候必须传入一个对象地址做为this指针

- 要点8是因为我们必须要显式指明类型,所以要有一个decltype辅助我们判断类型。

- 要点9和要点10就是实际模拟传入一个可调用对象或不传入可调用对象,只通过类型进行调用。

lambda, bind和function的简单准则

在性能关键点,一定要避免使用std::function或函数指针调用函数。尽可能避免使用bind和lambda。如果一定要使用,优先选择lambda,其次是bind,然后是函数指针,最后才是std::function。

https://stackoverflow.com/questions/49246242/efficiency-of-stdbind-vs-lambda

std::call_once 和 std::once_flag

原型:

1

2

template< class Callable, class... Args >

void call_once( std::once_flag& flag, Callable&& f, Args&&... args );

通过call_in_once执行的可调用对象可以保证在多线程的状态下仅被(一个线程)执行一次

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

once_flag my_flag1; //这个flag是一次性使用的。必须要全局。而且如果有两个东西需要call_once就要两个flag

once_flag my_flag2;

void func1(){

cout <<"func1" << endl;

}

void func2(int s){

cout <<"func2" << s << endl;

}

void thread_exe(){

//once_flag my_flag1; //错误 放在这里就是线程函数的局部变量。这样每个线程就会有自己的flag

//once_flag my_flag2;

call_once(my_flag1, func1);

call_once(my_flag2, func2, 1);

}

int main(){

thread mythread1(thread_exe);

thread mythread2(thread_exe);

mythread1.join();

mythread2.join();

return 0;

}

注意事项:

once_flag对象对于所有线程来说应该是全局变量(或等同于全局变量的形式)。因为once_flag对象只能被使用一次。如果是局部变量,则放在这里就是线程函数的局部变量。这样每个线程就会有自己的once_flag对象,就无法起作用。- 因为每一个

once_flag对象是一次性的。所以如果有两个东西需要call_once就要两个once_flag对象 - 当

flag没有标记为done,所有线程都会阻塞在once_flag这里,此时:- 如果某个

Callable抛出异常,则call_once会选择下一个等候的线程重新执行call_once动作。 - 如果成功执行了

Callable,解除所有等候线程的阻塞并给flag标记为done。

- 如果某个

参考:https://blog.csdn.net/qq_31175231/article/details/77916028

https://blog.csdn.net/XJF199001/article/details/51435845

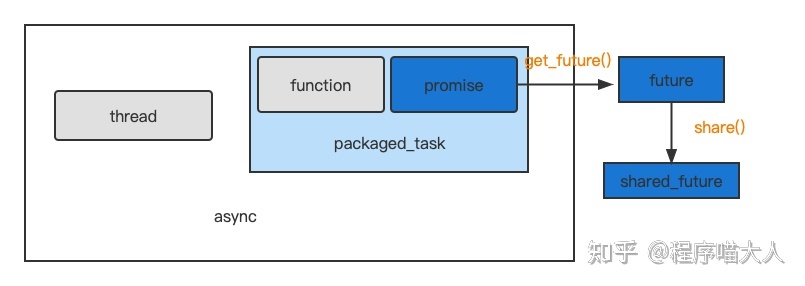

异步API。std::future, std::promise, std::packaged_task, std::async

想要进行多线程编程,这四个看起来高级的API是必不可少的。我们来看一看这一套异步编程套组里的四个组件到底有什么关系,他们是干什么的。

参考资料:https://segmentfault.com/a/1190000039201271

https://murphypei.github.io/blog/2019/04/cpp-concurrent-4

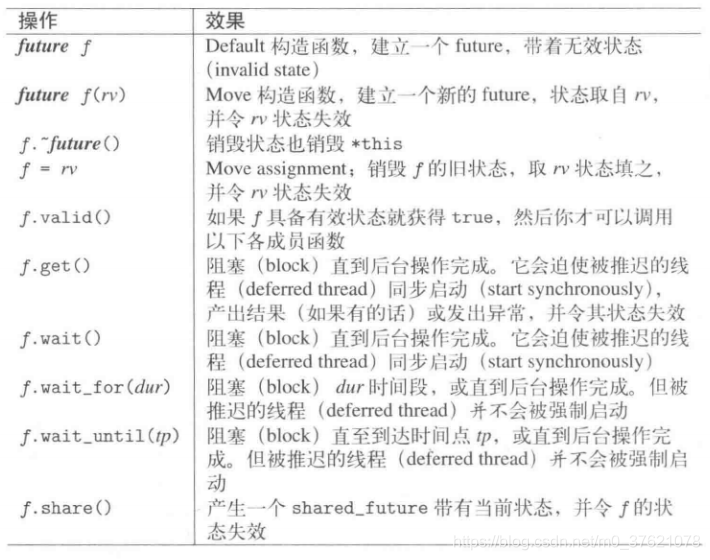

std::future / std::shared_future

< future >头文件功能允许对特定提供者设置的值进行异步访问,可能在不同的线程中。 这些提供程序(要么是promise 对象,要么是packaged_task对象,或者是对异步的调用async)与future对象共享共享状态:提供者使共享状态就绪的点与future对象访问共享状态的点同步。

上面这段话翻译过来就是我们可以理解为future是一个时间胶囊, 一个对象。这个对象的提供程序(如promise)里面储存了我们希望以后拿到的东西。然后我们用future来和提供程序连接起来,一旦共享状态转变为就绪,就可以拿到提供程序里面的东西。

- 所以说,future对象提供了一种让我们访问异步操作的结果的机制。

我们看一下future的正式定义和具体细节。

- future 是一个对象,可以从某个提供对象或函数中检索值,如果在不同线程中,则可以正确同步此访问。

- future的模板参数类型是其异步操作结果的类型。

- 它提供了一种访问异步操作结果的机制。从字面意思上看它表示未来,这个意思就非常贴切,因为它不是立即获取结果但是可以在某个时候以同步的方式来获取结果。我们可以通过查询

future的状态来获取异步操作的结果。future_status有三种状态:deferred:异步操作还未开始。共享状态包含一个延迟函数,因此只有在明确请求时才会计算结果。(主要用于async函数的std::launch::deferred参数。) (共享状态持有的函数正在延迟运行,结果将仅在显式请求时计算)ready:异步操作已经完成(共享状态就绪)timeout:异步操作超时。在指定的超时持续时间过去之前,共享状态尚未准备好。(共享状态在经过指定的等待时间内仍未就绪)

- “有效” future 对象,只能通过调用以下函数之一来构造:

asyncpromise::get_futurepackaged_task::get_future

- 默认构造的 future 对象是无效的(除非移动(move)分配一个有效的 future)。

- 在有效的 future 上调用

future::get会阻塞线程,直到提供程序准备好共享状态(通过设置值或异常)。这样,两个线程可以通过一个线程同步,等待另一个线程设置值。get()调用会改变其共享状态,不再可用,也就是说get()只能被调用一次,多次调用会触发异常。如果想要在多个线程中多次获取产出值需要使用shared_future。

- 共享状态的生存期至少要持续到与之关联的最后一个对象释放它或销毁它为止。因此,如果与 future 相关联,共享状态可以在最初获得它的对象(如果有的话)之后继续存在。

什么叫共享状态? – 整理自EMC++ 条款38

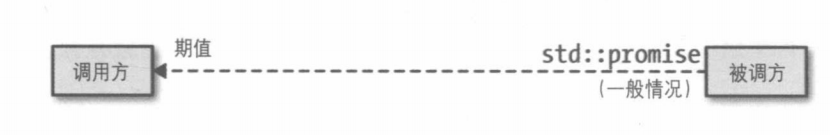

我们先来思考一下。我们知道了,我们可以通过promise,packaged_task拿到一个future对象。future对象是一个句柄,用于让我们访问异步操作的结果。在我们的直观想象中,可能调用方和被调用方的关系是这个样子:

- 这时候有了第一个问题。被调用方的结果储存在哪比较好?在调用方使用

get之前,可能这个异步操作已经执行完毕。同时,我们只能给promise设定值,而不能从promise中获取值。因此结果不会储存在被调用方的promise对象中。 - 同时,这个结果也不能存在调用方的

future对象中。因为我们可能通过future对象创建其他的shared_future对象。而shared_future对象可能会有多个。那么这么多对应同一个结果中的future对象中,哪一个应该包含结果呢?

所以future和结果应该储存在两个位置。这个位置被称之为共享状态。共享状态通常使用堆上的对象来表示,但是其型别、接口和实现标准皆未指定。标准库作者可以自由地用他们喜好的方法去实现共享状态。

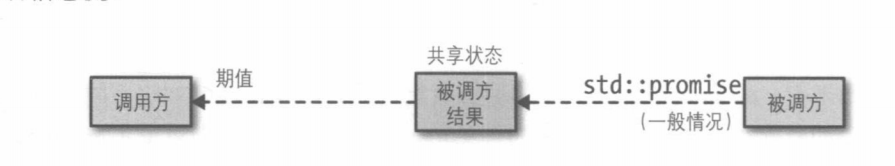

所以说,调用方和被调用方的关系是这个样子:

共享状态是有引用计数的。future,~packaged_task和promise对象的析构函数对其负责。所以在一些情况下,future对象的析构函数会由于共享状态的原因被阻塞。请查看async部分。同时部分资料来自这里

- 但是注意,只有

future对象的析构会阻塞,其他的不会。因为剩下两个对象的析构函数是抛弃(abandon)共享状态。而future对象的析构是释放(release)共享状态。

关于到底什么是共享状态,这个答案不太好。https://stackoverflow.com/questions/62241240/how-to-comprehend-stdfuture-shared-state

future::valid()

检查有效的共享状态

- 返回 future 对象当前是否与共享状态关联。

- 对于默认构造的 future 对象,此函数返回 false (除非将有效的 future 分配给移动对象)。

- future 只能由某些提供函数(如,

async,promise::get_future或packaged_task::get_future)使用有效的共享状态进行初始化。 - 一旦使用 future::get 检索了共享状态的值,则调用此函数返回 false (除非移动分配了一个新的 future).

返回值

- 如果对象与共享状态关联,则为 ture。

- 否则为假。

特别注意。返回值为true不代表此时共享状态已经就绪。只能表明对象与共享状态关联。

future::wait

阻塞并等待共享状态就绪(结果可用)

future::get

可以理解为包含了wait的操作。因为他调用了wait。

阻塞并等待共享状态就绪(结果可用),返回存储在共享状态中的值(或引发其异常)

- 当共享状态就绪时,返回存储在共享状态中的值(或引发其异常)。

- 如果共享状态尚未准备好(即提供程序尚未设置其值或异常),则该函数将阻塞调用线程直到准备就绪。在此前,调用了get的函数不会返回。

- 共享状态就绪后,该函数将取消阻塞并返回(或引发异常)以释放其共享状态。这时 future 对象不再有效:对于每个 future 的共享状态,此成员函数最多应被调用一次。

- 提供者准备好共享状态和返回此函数之间是同步的。

shared_future

std::shared_future 与 std::future 类似,但是 std::shared_future 可以拷贝、多个 std::shared_future 可以共享某个共享状态的最终结果(即共享状态的某个值或者异常)。shared_future 可以通过某个 std::future 对象隐式转换(参见 std::shared_future 的构造函数),或者通过 std::future::share() 显示转换,无论哪种转换,被转换的那个 std::future 对象都会变为 not-valid。std::shared_future 的成员函数和 std::future 大部分相同,这个地方就不一一展开了,需要的请查阅官方文档。

我们可以看到,想要创建一个有效的future对象必须依靠剩下的三个API。我们就来进一步看看剩下的几块内容。

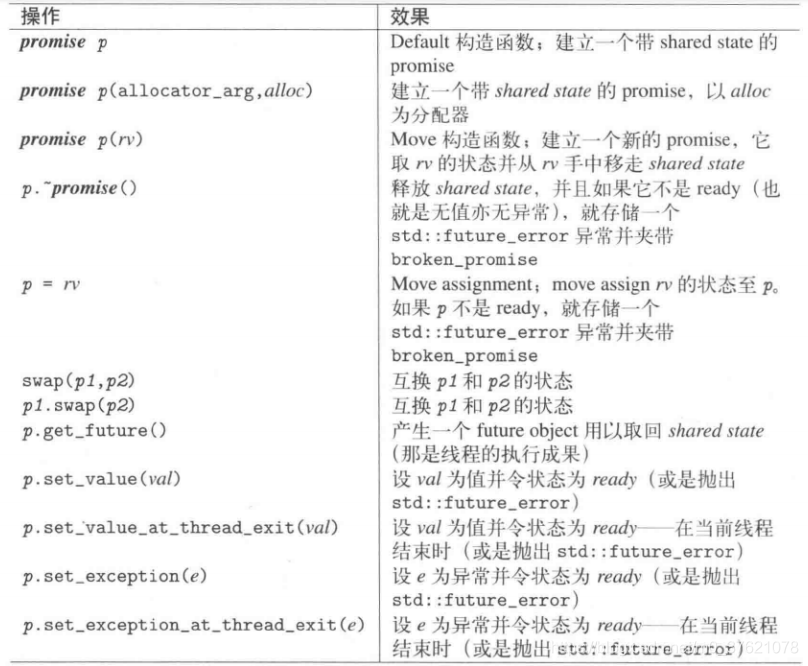

std::promise

promise是剩下三个当中最为“原始,底层“的API。

promise 本质是一个类似我们打印输出中占位符的东西,你可以理解它就是一个等待数据装填的坑,它是一个“承诺”,承诺未来会有相应的数据(模板实现)。因为这是一个“承诺”,所以创建的时候是没有东西的,所以我们需要知道这个异步操作什么时候能有东西,好实现“承诺”,所以 promise 可以通过调用 get_future() 返回一个 future 对象,让你去了解这个承诺是否完成了。因此,promise 是存放异步操作产出值的坑,而 future 是从其中获取异步操作结果,二者都是模板类型。

这里理解为我们的future对象是一个接口,建立起与promise对象的联系。我们使用promise对象来进行异步操作,所以能看到我们并不需要把future对象传入线程。但是我们会通过future对象去获知这个异步操作的结果是否就绪,也就是promise对象是否已经包含了我们期望的结果。然后我们可以通过future来获取结果。通过搭配future和promise,我们可以安全的进行线程间通信,不需要显式同步

promise和future就是一个异步操作的两个端点。我们把结果储存在promise,然后通过future提取。

promise是一个对象,由future对象(可能在另一个线程中)检索,并提供一个同步点。- 通过调用成员

get_future,可以将该共享状态与future对象关联。 调用之后,两个对象共享相同的共享状态:promise对象是异步提供程序,应在某个时候为共享状态设置一个值。set_valuefuture对象是一个异步返回对象,可以检索共享状态的值,并在必要时等待其准备就绪。- 理解为我们通过

promise的get_future来创建我们的future对象。之后通过future对象(来检索)获得一个共享状态(结果)。 - 注意 每个

std::promise对象只应当使用一次。

promise::set_value

- 以原子方式将值存储到共享状态(就是把promise对象储存的值设置好),并且改变该状态变为就绪状态。(设置共享状态)

- 如果与同一共享状态关联的future对象当前正在等待对

future::get的调用,则它将取消阻塞并返回val。- 因为future的get/wait会阻塞等待共享状态被设置完毕。

看看简单代码例子:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

//使用promise进行异步

void accumulate2(std::vector<int>::iterator first, //注意不太需要返回值了。因为异步返回的值被储存在了promise对象中

std::vector<int>::iterator last,

std::promise<int> accumulate_promise) //函数头要有promise对象定义。

{

int sum = std::accumulate(first, last, 0);

accumulate_promise.set_value(sum); // 将结果存入,并让共享状态变为就绪以提醒future

//如果不set_value,那么调用了future::get/wait的线程将一直被阻塞。

}

int main()

{

// 演示用 promise<int> 在线程间传递结果。

std::vector<int> numbers = { 1, 2, 3, 4, 5, 6 };

std::promise<int> accumulate_promise; //声明promise对象

std::future<int> accumulate_future(accumulate_promise.get_future()); //通过promise对象的get_future来初始化(获取)future对象

std::thread work_thread(accumulate2, numbers.begin(), numbers.end(),

std::move(accumulate_promise)); //启动线程。设置好执行函数和传入参数。注意必须要把promise对象一并传入(移入)

//!这里也可以用ref。但是我们accumulate2的函数头要了个值。promise又禁用了拷贝构造所以这里目前只可以move。如果accumulate2函数头改为&就可以用ref

// !可以用ref但是不推荐。因为如果你不转移所有权,万一你多个线程并发访问了promise,可能会有问题,

!而且这也不符合设计,一般来说只应该让一个线程持有promise

//accumulate_future.wait(); //等待结果 这个可以去掉,直接用get就可以

std::cout << "result=" << accumulate_future.get() << '\n'; //get阻塞住等待共享对象变为ready。然后获取结果。

work_thread.join(); //阻塞等待线程执行完成

getchar();

return 0;

}

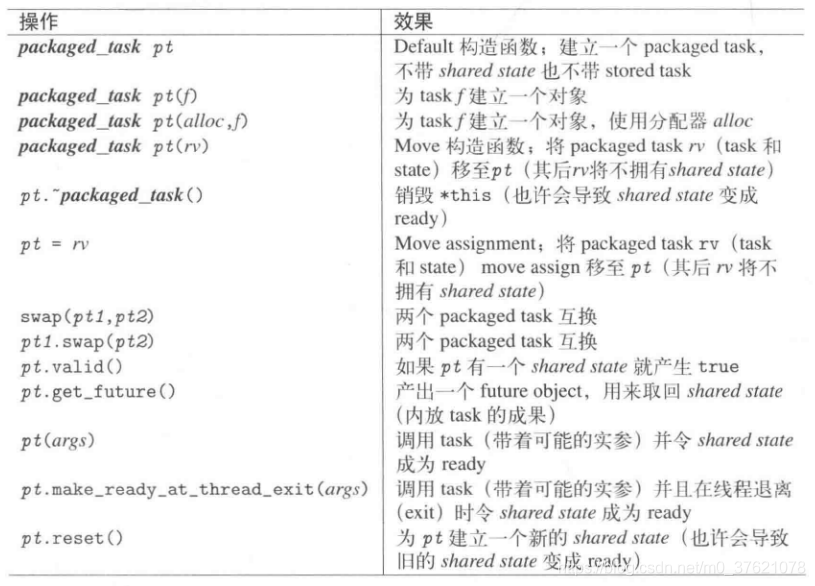

std::packaged_task

packaged_task比promise高级一点。直观来看就是参数少一点,操作少一点。稍后我们会有一个简单的对比。

packaged_task 是对一个任务的抽象,我们可以给其传递一个函数来完成其构造。相较于 promise,它应该算是更高层次的一个抽象,同样地,我们可以将任务投递给任何线程去完成,然后通过 packaged_task::get_future() 方法获取的 future 对象来获取任务完成后的产出值。总结来说,packaged_task 是连数据操作(比如set_value)都封装进去了的 promise。packaged_task 也是一个类模板,模板参数为函数签名,也就是传递函数的类型。

1

2

template <class T> packaged_task; // undefined

template <class Ret, class... Args> class packaged_task<Ret(Args...)>;

- std::packaged_task包装可调用对象,并允许异步检索其结果。(可调用对象是重点)

- 类似于 std::function, 但是会自动将其结果传输到 future 对象。

- 对象内部包含两个元素:

- 存储的任务是一些可调用对象(例如,函数指针,成员或函数对象的指针),其调用签名应采用 Args… 中类型的参数,并返回 Ret 类型的值。

- 共享状态,该状态能够存储调用存储的任务(类型为 Ret)的结果,并且可以通过 future 来异步访问。

- 通过调用成员 get_future 将共享状态与 future 对象关联。调用之后,两个对象共享相同的共享状态:

- packaged_task 对象是异步提供程序,通过调用存储的任务,可以在某个时刻将共享状态设置为就绪。

- future 对象是一个异步返回对象,可以检索共享状态的值,并在必要时等待其准备就绪。

看看代码实例,做一下比较:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

//? 使用packaged_task进行异步

int accumulate(std::vector<int>::iterator first,

std::vector<int>::iterator last) //注意函数头,我们没有像promise那样需要传入promise对象。

{

int sum = std::accumulate(first, last, 0);

return sum; //所以也不需要promise的set_value

}

int main()

{

// 演示用 packaged_task 在线程间传递结果。

std::vector<int> numbers = { 1, 2, 3, 4, 5, 6 };

std::packaged_task<int(std::vector<int>::iterator,std::vector<int>::iterator)> accumulate_task(accumulate);

//创建packaged_task对象。注意这里有区别,下面详说。

std::future<int> accumulate_future = accumulate_task.get_future(); //通过packaged_task对象的get_future来创建future对象

std::thread work_thread(std::move(accumulate_task), numbers.begin(), numbers.end()); //启动线程。注意这里有区别了。

/*

@ 使用move的主要原因还有一个就是按值传递函数参数会调用拷贝构造。packaged_task禁用了拷贝构造,要么传引用要么换成右值引用转移所有权。

*/

//accumulate_future.wait(); //等待结果 可以和下面的get合并

std::cout << "result=" << accumulate_future.get() << '\n';

work_thread.join(); //阻塞等待线程执行完成

getchar();

return 0;

}

我们来说一说几点具体区别

- 我们提到了,

packaged_task包装的是可调用对象。但是promise仅仅是一个包装着异步执行结果的对象。所以:packaged_task对象的模板类型是函数签名,因为他包装了可调用对象。- 所以线程执行的时候只需要移入

packaged_task对象即可,无需传入函数本身。因为已经被包装了。 - 所以包装的函数无需额外参数,函数内无需额外动作。

- 因为

promise会储存异步任务的结果,所以函数的返回值可以去掉。

其实理解了上面那一点,就理解了

packaged_task和promise的区别。可以简单理解为promise是一个包装了执行结果的对象。而packaged_task是一个包装了整个任务的对象,它不仅包装任务执行结果,而且包装任务本身。- 注意它的模板头参数

1

2

template <class _Ret, class... _ArgTypes>

class packaged_task<_Ret(_ArgTypes...)>

这样做的目的是让它的类型看起来更像函数。

std::async

async是最高级的一个API,代码简单,比较高层。它其实是封装了thread 和 packged_task的功能,使异步执行一个任务更为方便

async是函数模板,不是类模板。

1

2

3

4

5

6

7

8

9

unspecified policy (1)

template <class Fn, class... Args>

future<typename result_of<Fn(Args...)>::type>

async (Fn&& fn, Args&&... args);

specific policy (2)

template <class Fn, class... Args>

future<typename result_of<Fn(Args...)>::type>

async (launch policy, Fn&& fn, Args&&... args);

- 异步调用函数在某个时刻调用

fn(以args作为参数),返回时无需等待fn执行完成。(都说了是异步) - 可以通过返回的 future 对象(通过调用其成员

future::get)来访问fn返回的值。 - 第二个版本 (2) 允许调用者选择特定的启动策略,而第一个版本 (1) 使用自动选择,就好像调用 (2) 并将

launch::aysnc | launch::deferred作为策略。 - 该函数在共享状态下临时存储使用的线程处理程序。一旦完成 fn 的执行,共享状态将包含 fn 返回的值并准备就绪。

| launch::async | 启动一个新的线程以调用 fn (就像使用 fn 和 args 作为参数构造线程对象,并访问返回的 future 的共享状态将其联接)std::thread(std::forward<F>(f), std::forward<Args>(args)...) |

|---|---|

| launch::deferred | 意味着函数可能只会在std::async返回的future对象调用get或wait时执行。(函数在future对象调用了get或wait的时候才会开始执行)。不会产出新的线程。该任务会在调用线程中执行。当调用get或wait时,函数会同步执行,即调用者会阻塞直到函数运行结束。如果get或wait没有被调用,函数就绝对不会执行。 |

| launch::async | launch::deferred | 该功能自动(在某个时候)选择策略。这取决于系统和库的实现,他们通常会针对系统中当前的并发可用性进行优化 |

看一下细节

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

//? 使用async进行异步

int accumulate3(std::vector<int>::iterator first, std::vector<int>::iterator last){

std::cout <<"async begin" << std::endl;

int sum = std::accumulate(first, last, 0);

std::cout <<"async end" << std::endl;

return sum;

}

int main(){

std::cout <<"main begin" << std::endl;

std::vector<int> numbers = { 1, 2, 3, 4, 5, 6 };

std::future<int> accumulate_future = std::async(std::launch::async, accumulate3, numbers.begin(), numbers.end()); //ver1

std::future<int> accumulate_future = std::async(std::launch::deferred, accumulate3, numbers.begin(), numbers.end()); //ver2

Sleep(50); //睡眠五秒

std::cout << "result=" << accumulate_future.get() << '\n';

std::cout <<"main end" << std::endl;

return 0;

}

1

2

3

4

5

6

7

8

9

10

11

12

13

ver1 输出:

main begin

async begin

async end

result=21

main end

ver2 输出:

main begin

result=async begin

async end

21

main end

调用方式和thread很像,没什么区别。没有花里胡哨的东西。但是注意下细节。

- 在async模式中,一旦开始了调用,则会立刻创建子线程开始任务执行。所以我们看到尽管主线程睡眠了一下,但是并不影响异步线程的执行。所以async begin, async end和result=21是可以打印的。因为get的时候任务已经完成(或者是阻塞至任务完成)。

- 在deferred模式中,只有get/wait调用的时候任务才开始执行。所以result=先打印出来,然后直到调用get函数的时候,才开始执行任务,任务执行完毕后结果才能拿到,所以会先打印result=, 然后在调用线程(此处是主线程)中执行函数,拿到结果后打印21。

- 传参的时候如果需要使用只支持移动的参数比如unique_ptr,则必须使用move显式移动。

1

2

3

4

5

6

7

8

9

10

11

unique_ptr<int> testfunc(unique_ptr<int> ptr){

*ptr = *ptr + 1;

return ptr;

}

int main(){

unique_ptr<int> myptr = make_unique<int> (5);

future<unique_ptr<int>> my_future = async(std::launch::async, testfunc, move(myptr)); //显示使用move转移所有权。

cout << *(my_future.get()) << endl;

return 0;

}

- 如果async函数的返回值没有一个东西接住他(显式获取返回值),因为async会创建临时的future对象, 所以这个临时对象的析构函数会阻塞住调用线程直至异步线程执行完毕。因为我们不能让异步线程返回值的时候,这个临时对象已经被销毁了。

例子:

1

2

3

4

5

6

7

8

9

10

11

12

13

unique_ptr<int> testfunc(unique_ptr<int> ptr){

*ptr = *ptr + 1;

sleep(5); //睡眠五秒

return ptr;

}

int main(){

unique_ptr<int> myptr = make_unique<int> (5);

cout << "running" << endl;

async(std::launch::async, testfunc, move(myptr)); //卡在这里5秒。因为没有获取返回值。直到任务完成后赋值给临时future对象之后才能执行future临时对象的析构。

cout <<"blocked" << endl;

return 0;

}

这段代码执行的时候,调用线程会由于异步线程没有执行完毕,而且因为没有获取返回值,所以卡在async这行。直到异步线程执行完毕后赋值给临时future对象之后才能执行future临时对象的析构。才会继续输出blocked。

- 如果async函数的返回值有

future对象接住他(显式获取返回值),而且没有对future对象用使用get来阻塞主线程,因为满足下面的条件,所以主线程依旧会等待异步线程结束。因为该future对象的析构函数被阻塞了- 注意:此条件仅限于如下条件为真:

future对象以std::async的调用创建,且共享状态仍未就绪,且this是到共享状态的最后引用。- 最后面那个条件原文是:this was the last reference to the shared state. 我的理解其实是:这个

future对象是async调用创建的那个对象的最后的引用。- 也就是如果当前的

future对象此时是async调用创建的那个future对象,唯一与其有关联的实例。

- 也就是如果当前的

- 最后面那个条件原文是:this was the last reference to the shared state. 我的理解其实是:这个

- 注意:此条件仅限于如下条件为真:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

int accumulate3(std::vector<int>::iterator first, std::vector<int>::iterator last){

std::cout <<"async begin" << std::endl;

int sum = std::accumulate(first, last, 0);

sleep(5); //异步线程睡眠5秒

std::cout <<"async end" << std::endl;

return sum;

}

int exe(){

std::cout <<"exe begin" << std::endl;

std::vector<int> numbers = { 1, 2, 3, 4, 5, 6 };

std::future<int> accumulate_future = std::async(std::launch::async, accumulate3, numbers.begin(), numbers.end()); //通过async调用创建的future对象,且共享状态仍未就绪,且除了这个future对象以外,没有其他的对共享状态的引用。所以会阻塞。

//std::cout << "result=" << accumulate_future.get() << '\n'; 没有对`future`对象用使用`get`来阻塞主线程

std::cout <<"exe end" << std::endl;

return 200;

}

int main(){

int a = exe();

cout << a << endl;

return 0;

}

/*

输出:

exe begin

exe end

async begin

(睡眠五秒...)

async end

200

*/

我们可以看到,启用了异步线程,并且有future对象做为返回值,所以没有阻碍临时对象的析构。同时我们没有对future对象用使用get来阻塞主线程。但是虽然exe end被打印,但是因为满足上面的条件,所以该future对象的析构函数被阻塞了,这个调用线程依旧会被阻塞。所以这个函数的执行没有结束,所以main函数内的函数调用不会返回。所以调用线程依旧会等待异步线程结束而结束。

- 这种阻塞行为可以理解为该future临时对象的析构函数是对底层异步执行任务的线程实施了一次隐式的

join–emc++ 条款38- 在future的析构函数不被阻塞时(不满足上述条件的时候),可以理解为对底层线程实施了一次隐式的

detach。

- 在future的析构函数不被阻塞时(不满足上述条件的时候),可以理解为对底层线程实施了一次隐式的

future, packaged_tast, promise三者的关系

std::future用于访问异步操作的结果,而std::promise和std::packaged_task包住了future,它们内部都有一个future,promise包装的是一个值,packaged_task包装的是一个函数(异步操作本身),当需要获取线程中的某个值,可以使用std::promise,当需要获取线程函数返回值,可以使用std::packaged_task。

这三个东西和async都是互相搭配使用的。具体在哪个线程阻塞,哪个线程获取,哪个先哪个后,包括是传引用还是move都是依照情况而定的。

- packaged_task ≈ promise + function

- async ≈ thread + packaged_task

- 通过promise的get_future()可拿到future

- 通过future的share()可拿到shared_future

https://www.zhihu.com/question/547132461/answer/2657296340

杂项

- std::future提供访问异步操作结果的机制。std::future 只能与指定事件相关联,而 std::shared_future 就能关联多个事件。future对象本身并不提供同步访问(需要使用get/wait)。future的get()函数的设计包含移动语义,即只能调用一次,第二次调用时会报异常。shared_future的get()函数的设计包含复制语义,可以多次调用。std::shared_future对象可以通过std::future对象隐式转换,也可以通过显示调用std::future::share显示转换,在这两种情况下,原std::future对象都将变得无效。

- 当不着急让任务结果时,可以使用 std::async 启动一个异步任务。std::async 会返回一个 std::future 对象。get()等价与先调用wait()再调用get()。 std::launch::defered 表明函数调用延迟到wait()或get()函数调用时才执行,std::launch::async 表明函数必须在其所在的独立线程上执行。

- std::packaged_task<> 会将future与函数或可调用对象进行绑定。当 std::packaged_task 作为函数调用时,实参将由函数调用操作符传递至底层函数,并且返回值作为异步结果存储在 std::future 中。

- std::promise/std::future 对提供一种机制:future可以阻塞等待线程,提供数据的线程可以使用promise对相关值进行设置,并将future的状态置为“就绪”。

- 任何情况下,当future的状态还不是“就绪”时,调用 std::promise 或 std::packaged_task 的析构函数,将会存储一个与 std::future_errc::broken_promise 错误状态相关的 std::future_error 异常。

- 当调用抛出一个异常时,这个异常就会存储到future中,之后调用get()会抛出已存储的异常。

- std::current_exception() 来检索抛出的异常,可用 std::copy_exception() 作为替代方案, std::copy_exception() 会直接存储新的异常而不抛出。

- 因为 std::future 是只移动的,所以其所有权可以在不同的实例中互相传递,但只有一个实例可以获得特定的同步结果,而 std::shared_future 实例是可拷贝的,所以多个对象可以引用同一关联期望值的结果。

- 当多线程 在没有额外同步的情况下,访问一个独立的 std::future 对象时,就会有数据竞争和未定义的 行为。这是因为: std::future 模型独享同步结果的所有权,并且通过调用get()函数,一次性 的获取数据,这就让并发访问变的毫无意义——只有一个线程可以获取结果值,因为在第一 次调用get()后,就没有值可以再获取了。

- 在每一个 std::shared_future 的独立对象上成员函数调用返回的结果还是不同步的,所以为 了在多个线程访问一个独立对象时,避免数据竞争,可以使用两种方式:

- 锁

- 每一个线程有自己的shared_future对象,然后都通过自己的这个shared_future对象来获取结果。

async future搭配数组进行多线程accumulate的小例子

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

struct custom_acc{

int operator()(int a, future<int>& b){ //使用自定义累加。注意第一个参数是int。因为是把第二个参数作用域第一个参数上

//其次,这里future不要忘记指定模板参数。

//第三,这里future对象不可设置为const。因为get参数会更改future的内部状态。所以get不是const函数。const对象不能调用非const函数

return a + b.get();//使用get取出计算结果。

}

};

int acc_calc(std::vector<int>::iterator begin_iter, std::vector<int>::iterator end_iter){

return std::accumulate(begin_iter, end_iter,0); //这里老规矩。和async解析一样。任务函数。

}

int main(){

vector<int>my_vec(2000, 3); //要计算的数组

vector<future<int>> my_futures; //装有future对象的数组

int curpos = 0;

for(int i = 0; i < 10; i++){

my_futures.emplace_back(std::async(std::launch::async, acc_calc, my_vec.begin()+curpos, my_vec.begin()+curpos+200));

//这里我们在future对象数组内原地构造一个async对象。async对象传入启动方式,任务函数,和函数参数。

curpos+=200;

}

int ret = accumulate(my_futures.begin(), my_futures.end(), 0, custom_acc()); //这里我们逐个取出future对象数组并使用我们自定义的方法进行累加。

cout << ret << endl;

return 0;

}

atomic

https://youtu.be/ZQFzMfHIxng

无锁编程不一定会让程序更快,甚至会有副作用。它并不具有加速行为。

无锁编程不保证性能,不保证程序更快。

证明一个无锁代码的正确性非常难,如果必须使用无锁,最好使用库而不要自己搓轮子。

基本上如果架构没有太大问题,整个系统的瓶颈不会出现在某个锁上,换句话说,出现因为锁的性能瓶颈时大都是因为架构的问题,很多时候根本没必要上lock-free,一般的同步手段完全可以满足我们的需求。但是因为这样我们就可以不了解这个问题吗?我想作为一个IT行业未来的从业者不应该这样想,我们应该很清楚我们的代码经过了哪些变化,指令重排有时会对代码造成影响。

打算使用无锁编程提升性能之前,先检查其他部分,比如算法。

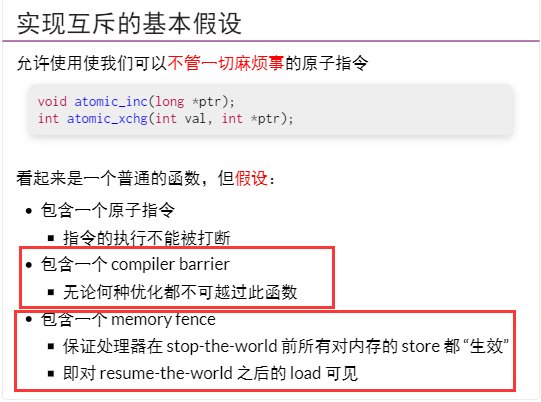

std::atomic_flag

std::atomic_flag 是原子布尔类型。不同于所有 std::atomic 的特化,它保证是免锁的。不同于 std::atomic<bool> , std::atomic_flag 不提供加载或存储操作。

std::atomic_flag是最简单的原子类型,这个类型的对象可以在两个状态间切换:

设置

清除

默认构造函数

构造一个新std::atomic_flag对象,不过未指明状态。这里未指定默认构造出来的std::atomic_flag实例是clear状态,还是set状态(c++20后默认构造函数初始化的状态为clear)。因为对象存储过程是静态的,所以初始化必须是静态的。std::atomic_flag 必须使用ATOMIC_FLAG_INIT进行初始化,这样构造出来的实例状态为clear。另外,atomic_flag不能被拷贝,也不能 move

std::atomic_flag::test_and_set

原子地更改 std::atomic_flag的状态为设置( true )并返回它先前保有的值。

std::atomic_flag::clear

原子地更改 std::atomic_flag的状态为清除( false )。

std::atomic_flag::wait/notify_one/notify_all

C++20内容

std::atomic

std::atomic模板的每个实例化和专门化都定义了一个原子类型。如果一个线程在另一个线程读取它时写入一个原子对象,那么行为就会被明确定义(参见关于数据竞争的详细信息的内存模型)。此外,对原子对象的访问可以建立线程间的同步,并按照std::memoryorder指定非原子性的内存访问。

std::atomic可以用任何简单的可复制的t实例化。同时std::atomic是不可复制的,不可移动的。注意初始化方式只能使用直接初始化。因为拷贝赋值和拷贝构造被禁用且不提供移动构造和移动赋值。这个初始化方式非原子。

- c++17后可以使用拷贝初始化。强制使用了复制省略技术。前提是右侧必须是prvalue临时对象

atomic不可以使用聚合初始化(aggregate initialization)

1 2

atomic<int> a = 5; //c++14错误, c++17 OK atomic<int> a(5);

具体特化类型参考https://zh.cppreference.com/w/cpp/atomic/atomic

特化成员函数操作,操作符重载加减之类的不讲了。

注意原子操作没有乘法和除法

- 注意带有赋值操作符的时候不能保证整条语句的原子性。

1 2 3 4

atomic<int> a(5); a = a + 5; //只保证读取a和a+5并且赋值分别是原子的。也就是原子读 + 原子写。不能保证原子读+写。 //也就是此时在原子操作:把A读出来 和原子操作:把A+5然后写回A 之间,任何指令都可以插入。 //可能存在把A读出来,然后其他操作把A修改为100000,然后A被修改为A+5然后写回。这样的情况。

c++20前,浮点类型不支持自增操作。

主

std::atomic模板可用任何满足可复制构造 (CopyConstructible) 及可复制赋值 (CopyAssignable) 的可平凡复制 (TriviallyCopyable) 类型T特化。若下列任何值为false则程序为非良构:std::is_trivially_copyable

::value std::is_copy_constructible

::value std::is_move_constructible

::value std::is_copy_assignable

::value std::is_move_assignable

::value

- 针对原子对象的操作并不一定全是“原子”的。也就是不一定保证无锁。需要看内存是否对齐了。可以使用

is_lock_free()进行判断针对该原子对象的操作是否是无锁的。详细查看这个视频

std::atomic::store

1

void store( T desired, std::memory_order order = std::memory_order_seq_cst ) noexcept;

原子地以 val 替换当前值。按照 order 的值影响内存。order 必须是 std::memory_order_relaxed 、 std::memory_order_release 或 std::memory_order_seq_cst 之一。否则行为未定义。

1

2

atomic<T> x;

x.store(y); //次操作在含以上等同于x = y;

std::atomic::load

1

T load( std::memory_order order = std::memory_order_seq_cst ) const noexcept;

原子地加载并返回原子变量的当前值。按照 order 的值影响内存。

order 必须是 std::memory_order_relaxed、 std::memory_order_consume 、 std::memory_order_acquire 或 std::memory_order_seq_cst 之一。否则行为未定义。

1

2

atomic<T> x;

T y = x.load(); //此操作在含义上等同于 T y = x;

std::atomic::operator=

等于store() 注意用法。

1

2

atomic<int> a;

a = 3;

这个等号不是拷贝赋值的那个等号。

std::atomic::operator T

等于load()

std::atomic::exchange

1

T exchange( T desired, std::memory_order order = std::memory_order_seq_cst )

原子地以 desired 替换底层值。操作为读-修改-写操作。根据 order 的值影响内存。

返回调用前原子对象的值。

1

2

atomic<T> x;

T z = x.exchange(y); //此操作在含义上等同 z = x; x = y;

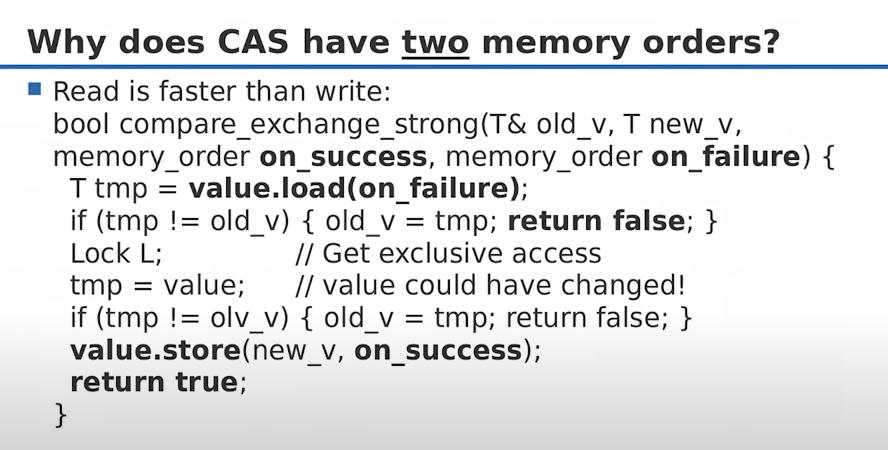

std::atomic::compare_exchange_weak/strong

上面的exchange只是原子交换。但是这个就是著名的CAS

1

2

3

4

5

6

bool compare_exchange_weak( T& expected, T desired,

std::memory_order success,

std::memory_order failure ) noexcept;

bool compare_exchange_strong( T& expected, T desired,

std::memory_order success,

std::memory_order failure ) noexcept;

- 原子地比较

*this和expected的对象表示,而若它们逐位相等,则以desired替换前者(进行读修改写操作)。否则,将*this中的实际值加载进expected(进行加载操作)- 若成功更改底层原子值则返回

true,否则为false。

- 若成功更改底层原子值则返回

归纳一下这个函数的使用要点:

- 当前值与期望值(expect)相等时,修改当前值为设定值(desired),返回

true - 当前值与期望值(expect)不等时,将期望值(expect)修改为当前值,返回

false- 这一行非常关键。如果当前值和期望值不相等,会修改期望值而不是修改当前值。所以下面我们实现简单的自旋锁的时候必须要搭配

while,而且while内需要把值改回去。

- 这一行非常关键。如果当前值和期望值不相等,会修改期望值而不是修改当前值。所以下面我们实现简单的自旋锁的时候必须要搭配

- 这个函数可能在满足

true的情况下仍然返回false,所以只能在循环里使用,否则可以使用它的strong版本- weak版和strong版的区别:

- weak版本的CAS允许偶然出乎意料的返回(比如在当前值和期待值一样的时候却返回了false),不过在一些循环算法中,这是可以接受的。通常它比起strong有更高的性能。

- 如果此事偶然发生,可以对期望值(expect)进行检查。期望值应该不会改变。

- 用人话说就是

compare_exchange_weak有可能在当前值与expected相等时仍然不执行交换并返回false;compare_exchange_strong则不会有这个问题. weak 版本能让编译器在一些平台下生成一些更优的代码, 在 x86 下是没区别的.

- weak版和strong版的区别:

- 当前值与期望值(expect)相等时,修改当前值为设定值(desired),返回

1

2

3

4

5

atomic<T> x;

bool success = x.compare_exchange_weak(y, z);

//此操作含义为:

//如果x == y, 则让 x = z 并且返回true

//如果x != y, 则让 y = x 并且返回false

有没有注意到为啥这个函数有俩memory_order?

为了支持指定两个内存顺序: 成功时的内存顺序和失败时的内存顺序. 一个用于读取一个用于写入

在 x86 下 compare_exchange_* 会被编译成一条 cmpxchgl 指令, 因此操作是原子且无锁的.

https://blog.csdn.net/feikudai8460/article/details/107035480

https://luyuhuang.tech/2022/10/30/lock-free-queue.html

额外说一下fetch系列操作。这里就说一下fetch_add

指针特化的fetch_add在下面。这里针对普通类型。

1

2

T fetch_add( T arg,

std::memory_order order = std::memory_order_seq_cst ) noexcept;

- 原子地以值和

arg的算术加法结果替换当前值。运算是读修改写操作。按照order的值影响内存。 - 其实就是

+= - 但是返回值是原值!!!!!!

1

2

3

4

atomic<int> x(200);

int z = x.fetch_add(20); //z = x; x += y。

cout << z << endl; //z是x修改前的值。200

cout << x.load() << endl; //x是220

std::atomic<T*>特化

- 针对指针类型的特化,代表指针指向的对象不是原子的。而是代表这个指针本身是原子的。

- 同样不可拷贝构造和拷贝赋值。

- 但是他可以通过合适的指针类型(不一定非得是原子的)进行构造和赋值。

针对指针特化类型的特殊操作

特化的函数这里主要简单介绍fetch_add, fetch_sub, operator++, operator--

自增自减没啥好说的。这里就举个fetch_add的例子

fetch_add1 2

T* fetch_add( std::ptrdiff_t arg, std::memory_order order = std::memory_order_seq_cst ) noexcept;

原子地以值和

arg的算术加法结果替换当前值。运算是读修改写操作。按照order的值影响内存。- 其实就是

+=操作。注意这个加法是指针加法。

std::atomic::wait/notify_one/notify_all

C++20内容

atomic 支持操作总结

| 操作 | atomic_flag | atomic<bool> | atomic<T*> | atomic<integral_type> | atomic<other_type> |

|---|---|---|---|---|---|

| test_and_set | ✓ | ||||

| clear | ✓ | ||||

| is_lock_free | ✓ | ✓ | ✓ | ✓ | |

| load | ✓ | ✓ | ✓ | ✓ | |

| store | ✓ | ✓ | ✓ | ✓ | |

| exchange | ✓ | ✓ | ✓ | ✓ | |

| compare_exchange_weak/strong | ✓ | ✓ | ✓ | ✓ | |

| fetch_add, += | ✓ | ✓ | |||

| fetch_sub, -= | ✓ | ✓ | |||

| fetch_or, |= | ✓ | ||||

| fetch_and, &= | ✓ | ||||

| fetch_xor, ^= | ✓ | ||||

| ++,– | ✓ | ✓ |

- 关于用户定义类型,有非常严格要求。建议去官方文档看。

修改顺序, 指令重排,缓存一致性,内存屏障和内存模型

修改顺序

对一个原子变量的所有修改操作总是存在一定的先后顺序, 且所有线程都认可这个顺序, 即使这些修改操作是在不同的线程中执行的. 这个所有线程一致同意的顺序就称为修改顺序 (modification order). 这意味着

- 两个修改操作不可能同时进行, 一定存在一个先后顺序. 这很容易理解, 因为这是原子操作必须保证的, 否则就有数据竞争的问题.

- 即使每次运行的修改顺序可能都不同, 但所有线程看到的修改顺序总是一致的. 如果线程 a 看到原子变量 x 由 1 变成 2, 那么线程 b 就不可能看到 x 由 2 变成 1.

无论使用哪种内存顺序, 原子变量的操作总能满足修改顺序一致性, 即使是最松散的 memory_order_relaxed. 我们来看一个例子

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

std::atomic<int> a{0};

void thread1() {

for (int i = 0; i < 10; i += 2)

a.store(i, std::memory_order_relaxed);

}

void thread2() {

for (int i = 1; i < 10; i += 2)

a.store(i, std::memory_order_relaxed);

}

void thread3(vector<int> *v) {

for (int i = 0; i < 10; ++i)

v->push_back(a.load(std::memory_order_relaxed));

}

void thread4(vector<int> *v) {

for (int i = 0; i < 10; ++i)

v->push_back(a.load(std::memory_order_relaxed));

}

int main() {

vector<int> v3, v4;

std::thread t1(thread1), t2(thread2), t3(thread3, &v3), t4(thread4, &v4);

t1.join(), t2.join(), t3.join(), t4.join();

for (int i : v3) cout << i << " ";

cout << endl;

for (int i : v4) cout << i << " ";

cout << endl;

return 0;

}

上面的代码创建了 4 个线程. thread1 和 thread2 分别将偶数和奇数依次写入原子变量 a, thread3 和 thread4 则读取它们. 最后输出 thread3 和 thread4 每次读取到的值. 程序运行的结果可能是这样的

1

2

3

4

5

1 8 7 7 7 9 9 9 9 9

0 2 8 8 8 7 9 9 9 9

-------------------

1 2 5 6 9 9 9 8 8 8

1 3 2 5 9 8 8 8 8 8

虽然每次运行的修改顺序不同, 各个线程也不太可能看到每次修改的结果, 但是它们看到的修改顺序是一致的. 例如 thread3 看到的顺序是 8 7 9, 那么thread4看到的顺序也是8 7 9. thread3看到的顺序是1 5 9 8 那么 thread4看到的顺序一样是1 5 9 8

指令重排

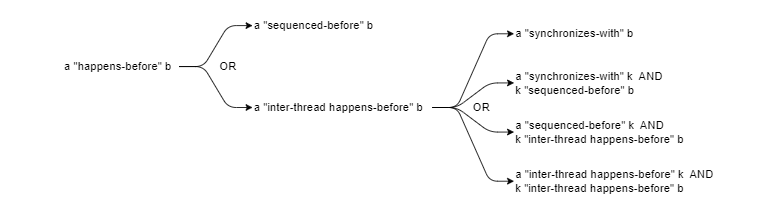

Happens-Before 关系

A、B 是两个在多核 CPU 上执行的操作。如果 A happens-before B,那么 A 所产生的内存变化会在 B 操作执行之前被看到(visible)。

简而言之, 如果操作 a “happens-before” 操作 b, 则操作 a 的结果对于操作 b 可见. happens-before 的关系可以建立在用一个线程的两个操作之间, 也可以建立在不同的线程的两个操作之间.

不管我们使用什么编程语言,在同一个线程下的顺序语句总是遵循 happens-before 原则的。

就像下面代码所示:

1

2

3

4

5

6

7

8

int a, b;

void foo() {

a = 42;

b = a;

assert(b == 42);

}

在单线程的情况下,断言是永远不会为假的。(不然这还怎么写程序…)

但这并不代表 b 在内存中后于 a 被修改。就像下面这段伪代码所示的:

1

2

3

mov %eax, 42

mov (b), %eax

mov (a), %eax

虽然这并不能说明编译器就是这么处理的,但足以说明程序语义上的 happens-before 不能代表操作是真的 happened before 了。

Happens-before 的第一种场景: sequenced before(单线程)

单线程的情况很容易理解. 函数的语句按顺序依次执行, 前面的语句先执行, 后面的后执行. 正式地说, 前面的语句总是 “sequenced-before” 后面的语句. 显然, 根据定义, sequenced-before 具有传递性:

- 如果操作

a“sequenced-before” 操作k, 且操作k“sequenced-before” 操作b, 则操作a“sequenced-before” 操作b.

Sequenced-before 可以直接构成 happens-before 的关系. 如果操作 a “sequenced-before” 操作 b, 则操作 a “happens-before” 操作 b. 这是最基本的场景:

1

2

a = 42; // (1)

cout << a << endl; // (2)

语句 (1) 在语句 (2) 的前面, 因此语句 (1) “sequenced-before” 语句 (2), 也就是 (1) “happens-before” 语句 (2). 所以 (2) 可以打印出 (1) 赋值的结果且没有任何问题

Happens-before 的第二种场景: synchronizes-with 和 inter-thread happens-before(多线程)

一般来说, 如果在多个线程间没有正确的同步操作, 就无法保证两个操作之间有 happens-before 的关系. 如果我们通过一些手段, 让不同线程的两个操作同步, 我们称这两个操作之间有 synchronizes-with 的关系. 稍后我们会详细讨论如何组合使用 6 种内存顺序, 让两个操作达成 synchronizes-with 的关系.

如果线程 1 中的操作 a “synchronizes-with” 线程 2 中的操作 b, 则操作 a “inter-thread happens-before” 操作b. 此外 synchronizes-with 还可以 “后接” 一个 sequenced-before 关系组合成 inter-thread happens-before 的关系:

- 如果操作 a “synchronizes-with” 操作 k, 且操作 k “sequenced-before” 操作 b, 则操作 a “inter-thread happens-before” 操作 b.

Inter-thread happens-before 关系则可以 “前接” 一个 sequenced-before 关系以延伸它的范围; 而且 inter-thread happens-before 关系具有传递性:

- 如果操作 a “sequenced-before” 操作 k, 且操作 k “inter-thread happens-before” 操作 b, 则操作 a “inter-thread happens-before” 操作 b.

- 如果操作 a “inter-thread happens-before” 操作 k, 且操作 k “inter-thread happens-before” 操作 b, 则操作 a “inter-thread happens-before” 操作 b.

正如它的名字暗示的, 如果操作 a “inter-thread happens-before” 操作 b, 则操作 a “happens-before” 操作 b. 下图展示了这几个概念之间的关系:

注意, 虽然 sequenced-before 和 inter-thread happens-before 都有传递性, 但是 happens-before 没有传递性.

例子1:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

int data;

std::atomic_bool flag { false };

// Execute in thread A

void producer() {

data = 42; // (1)

flag.store(true); // (2)

}

// Execute in thread B

void consume() {

while (!flag.load()); // (3)

assert(data == 42); // (4)

}

让两个函数分别在两个线程中运行,(4) 所示的断言将有一定几率 为假,这是为什么呢?虽然我们使用原子量 flag 作为“同步信号”,而且同一个线程中 happens-before 原则也一定会被遵循,但我们并不能保证 (4) 执行时 (1) 的修改一定会被 B 线程看到, 可能是2-3-4-1这个顺序。这是由于现代处理器对于程序可能会采取指令重排来提高运行效率,CPU 的读写 Cache 也可能并没有写回内存。

所以,企图在多线程环境中通过某原子量来做非原子量的 Synchronization 并不是可靠的(当没有 Memory Order 的约束时候)。

当然,上面的代码其实基本上不会为假,因为 C++ 默认使用 memory_order_seq_cst顺序约束。而且 x86 架构中也做不到松弛(memory_order_relaxed)内存模型。也就是说,这种过于松弛的模型理论上存在,但其实不会发生。因为如果允许这个级别的松弛那么代码没法写了。

例子2, 假设下面的代码中 unlock() 操作 “synchronizes-with” lock() 操作:

1

2

3

4

5

6

7

8

9

void thread1() {

a += 1 // (1)

unlock(); // (2)

}

void thread2() {

lock(); // (3)

cout << a << endl; // (4)

}

假设直到 thread1 执行到 (2) 之前, thread2 都会阻塞在 (3) 处的 lock() 中. 那么可以推导出:

- 根据语句顺序, 有 (1) “sequenced-before” (2) 且 (3) “sequenced-before” (4);

- 因为 (2) “synchronizes-with” (3) 且 (3) “sequenced-before” (4), 所以 (2) “inter-thread happens-before” (4);

- 因为 (1) “sequenced-before” (2) 且 (2) “inter-thread happens-before” (4), 所以 (1) “inter-thread happens-before” (4); 所以 (1) “happens-before” (4).

因此 (4) 可以读到 (1) 对变量 a 的修改

在上面的例子中,我们主要讲述的是指令重排。但是内存屏障不仅仅是为了防止指令重排,也会解决缓存一致性问题。在最后我们会详细探讨这其中的关系。

缓存一致性

我们都知道二维数组横向遍历比纵向遍历要快。为什么?

- 我们知道有L1 L2 L3三级cache。然后才是内存。CPU需要把内存里的数据读到cache中。但是CPU为了最大化利用cache line的能力,一般会读取一个固定大小的数据区块。一般来说 L3 Cache 比 L1 Cache 和 L2 Cache 大很多,这是因为 L1 Cache 和 L2 Cache 都是每个 CPU 核心独有的,而 L3 Cache 是多个 CPU 核心共享的。

这也就是为什么连续内存操作会比较快,也是为什么内存对齐十分重要。因为如果起点在奇数位就会有二次操作。

CPU cache到内存的映射有三种:

- 直接映射

- 直接映射通俗易懂。就是内存地址映射到的cache line是固定的。比较好找。但是问题在于这个数量非常少。如果多个数据抢占同一个cache line,就会发生cache频繁的换入换出。

- 全相连映射

- 全相连映射的意思是任意一个内存地址可以映射到任意一个cache line。也就是见缝插针。问题在于在寻找一个内存地址是否已被映射的时候,需要遍历每一个cacheline

- 组相连映射

- 组相连映射也就是组间采用直接映射,组内采用全相连映射。

CPU cache读取过程

假设我们的L1 Cache Line是64字节:

比如,有一个 int array[100] 的数组,当载入 array[0] 时,由于这个数组元素的大小在内存只占 4 字节,不足 64 字节,CPU 就会顺序加载数组元素到 array[15],意味着 array[0]~array[15] 数组元素都会被缓存在 CPU Cache 中了,因此当下次访问这些数组元素时,会直接从 CPU Cache 读取,而不用再从内存中读取,大大提高了 CPU 读取数据的性能。

事实上,CPU 读取数据的时候,无论数据是否存放到 Cache 中,CPU 都是先访问 Cache,只有当 Cache 中找不到数据时,才会去访问内存,并把内存中的数据读入到 Cache 中,CPU 再从 CPU Cache 读取数据。

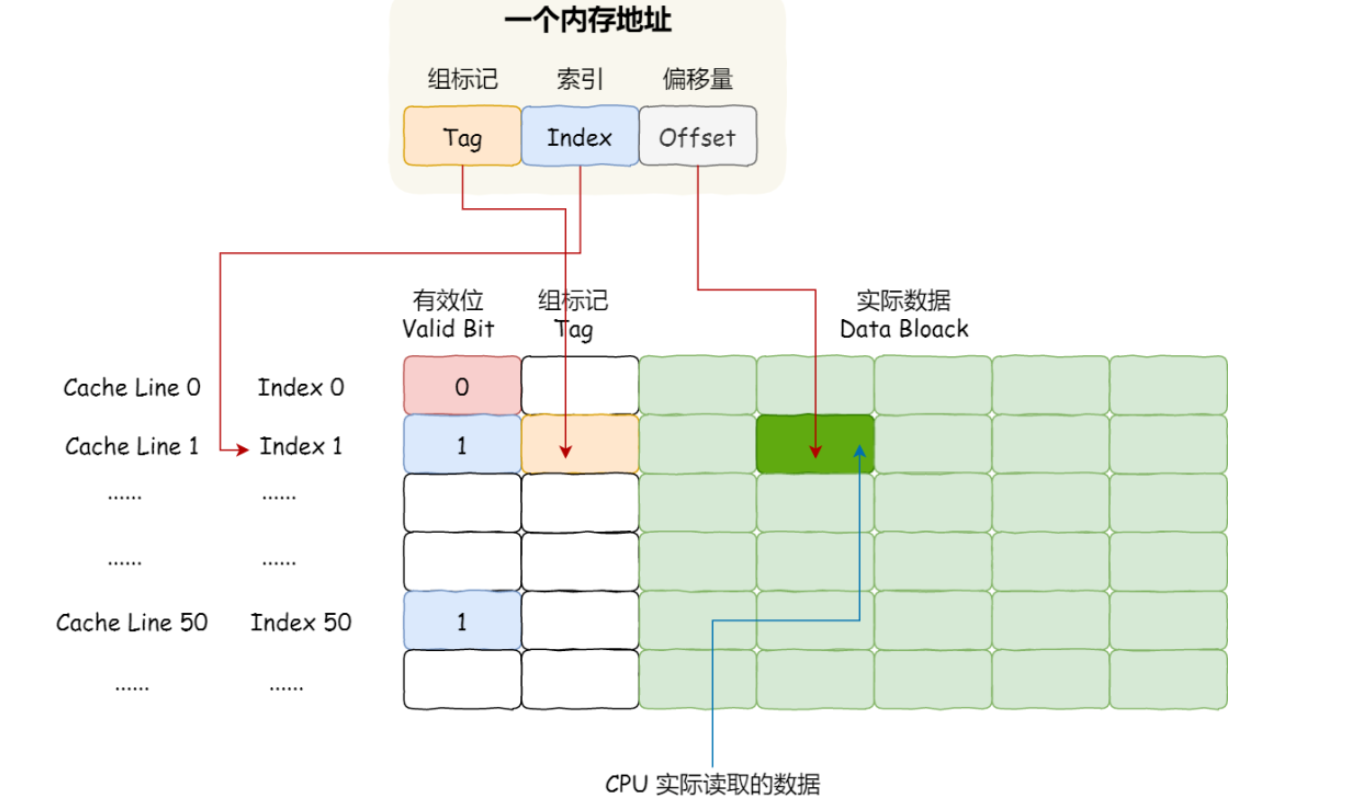

我们刚提到过直接映射会把内存的固定地址映射到固定的cache line。一般来说是通过取模运算来确定的。所以会存在多个内存区块映射到同一个cache line位置上。这时候就要区分他们了。为了区别不同的内存块,在对应的 CPU Line 中我们还会存储一个组标记(Tag)。这个组标记会记录当前 CPU Line 中存储的数据对应的内存块,我们可以用这个组标记来区分不同的内存块。

除了组标记信息外,CPU Line 还有两个信息:

- 一个是,从内存加载过来的实际存放数据(Data)。

- 另一个是,有效位(Valid bit),它是用来标记对应的 CPU Line 中的数据是否是有效的,如果有效位是 0,无论 CPU Line 中是否有数据,CPU 都会直接访问内存,重新加载数据。

CPU 在从 CPU Cache 读取数据的时候,并不是读取 CPU Line 中的整个数据块,而是读取 CPU 所需要的一个数据片段,这样的数据统称为一个字(*Word*)。那怎么在对应的 CPU Line 中数据块中找到所需的字呢?答案是,需要一个偏移量(Offset)。

因此,一个内存的访问地址,包括组标记、CPU Line 索引、偏移量这三种信息,于是 CPU 就能通过这些信息,在 CPU Cache 中找到缓存的数据。而对于 CPU Cache 里的数据结构,则是由索引 + 有效位 + 组标记 + 数据块组成。

如果内存中的数据已经在 CPU Cahe 中了,那 CPU 访问一个内存地址的时候,会经历这 4 个步骤:

- 根据内存地址中索引信息,计算在 CPU Cahe 中的索引,也就是找出对应的 CPU Line 的地址;

- 找到对应 CPU Line 后,判断 CPU Line 中的有效位,确认 CPU Line 中数据是否是有效的,如果是无效的,CPU 就会直接访问内存,并重新加载数据,如果数据有效,则往下执行;

- 对比内存地址中组标记和 CPU Line 中的组标记,确认 CPU Line 中的数据是我们要访问的内存数据,如果不是的话,CPU 就会直接访问内存,并重新加载数据,如果是的话,则往下执行;

- 根据内存地址中偏移量信息,从 CPU Line 的数据块中,读取对应的字。

问题在于,我们并不是只读数据。我们还会写入。那么如果数据写入 Cache 之后,内存与 Cache 相对应的数据将会不同,这种情况下 Cache 和内存数据都不一致了,于是我们肯定是要把 Cache 中的数据同步到内存里的。

问题来了,那在什么时机才把 Cache 中的数据写回到内存呢?为了应对这个问题,下面介绍两种针对写入数据的方法:

写直达(Write Through)

保持内存与 Cache 一致性最简单的方式是,把数据同时写入内存和 Cache 中,这种方法称为写直达(*Write Through*)。

在这个方法里,写入前会先判断数据是否已经在 CPU Cache 里面了:

- 如果数据已经在 Cache 里面,先将数据更新到 Cache 里面,再写入到内存里面;

- 如果数据没有在 Cache 里面,就直接把数据更新到内存里面。

写直达法很直观,也很简单,但是问题明显,无论数据在不在 Cache 里面,每次写操作都会写回到内存,这样写操作将会花费大量的时间,无疑性能会受到很大的影响。

写回(Write Back)

- 既然写直达由于每次写操作都会把数据写回到内存,而导致影响性能,于是为了要减少数据写回内存的频率,就出现了写回(*Write Back*)的方法。

- 在写回机制中,当发生写操作时,新的数据仅仅被写入 Cache Block 里,只有当修改过的 Cache Block「被替换」时才需要写到内存中,减少了数据写回内存的频率,这样便可以提高系统的性能。

- 如果当发生写操作时,数据已经在 CPU Cache 里的话,则把数据更新到 CPU Cache 里,同时标记 CPU Cache 里的这个 Cache Block 为脏(Dirty)的,这个脏的标记代表这个时候,我们 CPU Cache 里面的这个 Cache Block 的数据和内存是不一致的,这种情况是不用把数据写到内存里的;

- 如果当发生写操作时,数据所对应的 Cache Block 里存放的是「别的内存地址的数据」的话,就要检查这个 Cache Block 里的数据有没有被标记为脏的,如果是脏的话,我们就要把这个 Cache Block 里的数据写回到内存,然后再把当前要写入的数据,写入到这个 Cache Block 里,同时也把它标记为脏的;如果 Cache Block 里面的数据没有被标记为脏,则就直接将数据写入到这个 Cache Block 里,然后再把这个 Cache Block 标记为脏的就好了。

可以发现写回这个方法,在把数据写入到 Cache 的时候,只有在缓存不命中,同时数据对应的 Cache 中的 Cache Block 为脏标记的情况下,才会将数据写到内存中,而在缓存命中的情况下,则在写入后 Cache 后,只需把该数据对应的 Cache Block 标记为脏即可,而不用写到内存里。

这样的好处是,如果我们大量的操作都能够命中缓存,那么大部分时间里 CPU 都不需要读写内存,自然性能相比写直达会高很多。

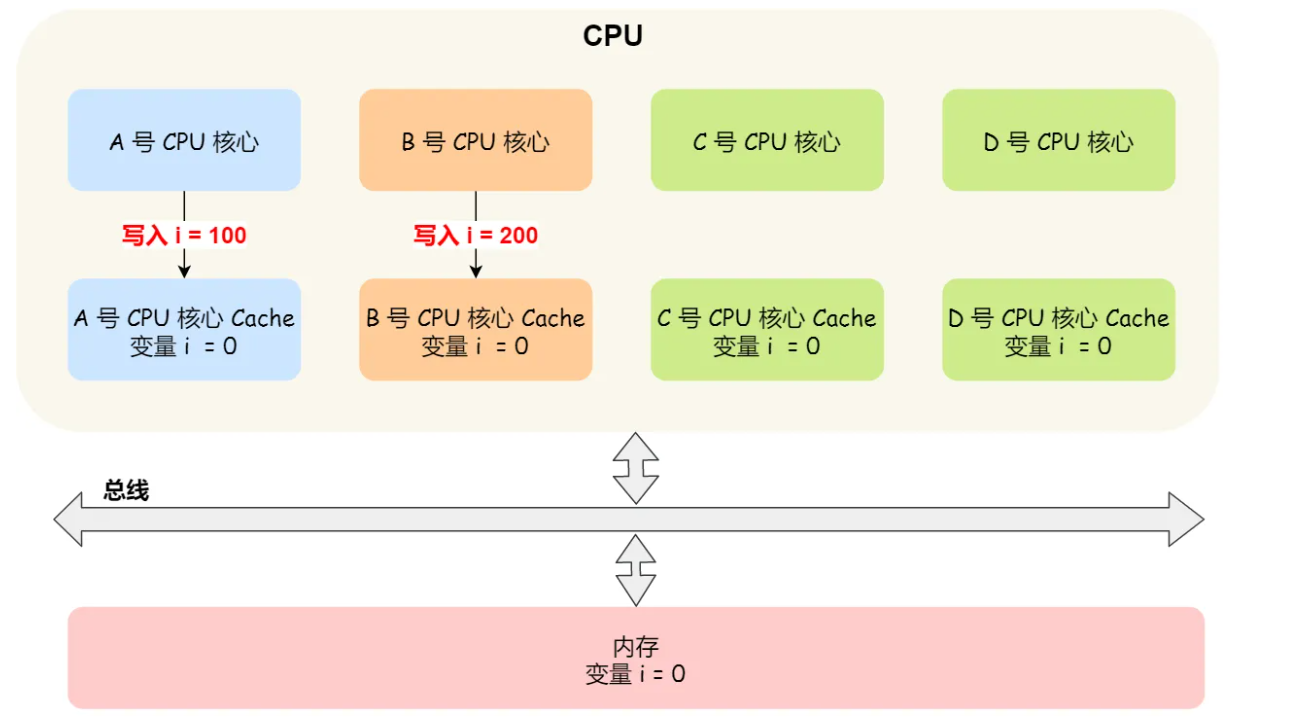

现在有一个问题。我们东西确实是写入L1/L2 cache了。但是L1/L2 cache是每个核心独有的。也就是说,有可能在一个核心修改完数据后,修改的数据还在自己的缓存里。另一个核心从自己的缓存里读就会读到没有修改过的值。

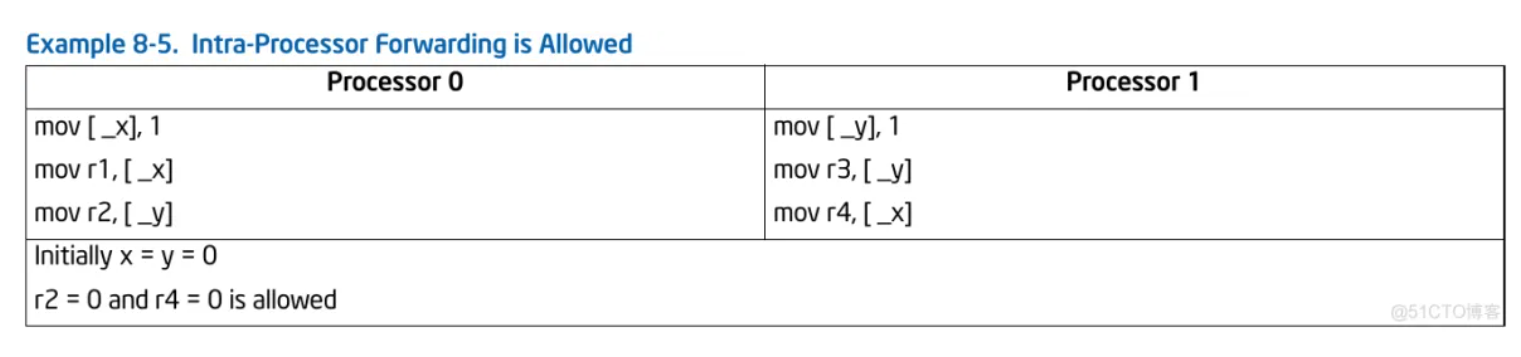

- 这里的意思是有可能r2 = 0 且 r4 = 0。为什么?

- 我们可能会回答指令重排。但是X86是不允许写-写重排的。所以导致这个情况的就是我们本节的缓存一致性。

- 但是具体原因是什么呢?我们先看看MESI协议。

那么,要解决这一问题,就需要一种机制,来同步两个不同核心里面的缓存数据。要实现的这个机制的话,要保证做到下面这 2 点:

- 第一点,某个 CPU 核心里的 Cache 数据更新时,必须要传播到其他核心的 Cache,这个称为写传播(*Wreite Propagation*);

- 第二点,某个 CPU 核心里对数据的操作顺序,必须在其他核心看起来顺序是一样的,这个称为事务的串形化(*Transaction Serialization*)。

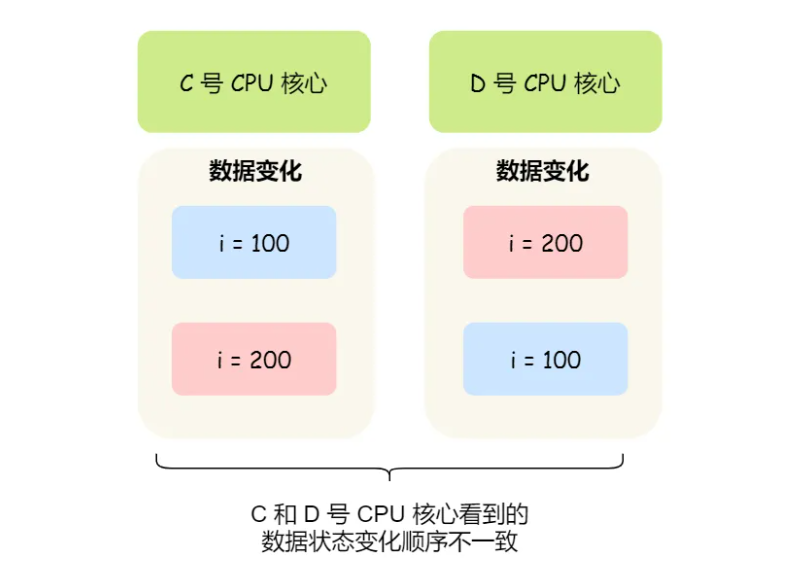

第一点写传播很容易就理解,当某个核心在 Cache 更新了数据,就需要同步到其他核心的 Cache 里。而对于第二点事务事的串形化,我们举个例子来理解它。:

- 假设我们有一个含有 4 个核心的 CPU,这 4 个核心都操作共同的变量

i(初始值为 0 )。A 号核心先把i值变为100,而此时同一时间,B 号核心先把i值变为200,这里两个修改,都会「传播」到 C 和 D 号核心。

那么问题就来了,C 号核心先收到了 A 号核心更新数据的事件,再收到 B 号核心更新数据的事件,因此 C 号核心看到的变量 i 是先变成 100,后变成 200。

而如果 D 号核心收到的事件是反过来的,则 D 号核心看到的是变量 i 先变成 200,再变成 100,虽然是做到了写传播,但是各个 Cache 里面的数据还是不一致的。

所以,我们要保证 C 号核心和 D 号核心都能看到相同顺序的数据变化,比如变量 i 都是先变成 100,再变成 200,这样的过程就是事务的串形化。

要实现事务串形化,要做到 2 点:

- CPU 核心对于 Cache 中数据的操作,需要同步给其他 CPU 核心;

- 要引入「锁」的概念,如果两个 CPU 核心里有相同数据的 Cache,那么对于这个 Cache 数据的更新,只有拿到了「锁」,才能进行对应的数据更新。

MESI 协议

MESI 协议其实是 4 个状态单词的开头字母缩写,分别是:

- Modified,已修改

- Exclusive,独占

- Shared,共享

- Invalidated,已失效

这四个状态来标记 Cache Line 四个不同的状态。

- 「已修改」状态就是我们前面提到的脏标记,代表该 Cache Block 上的数据已经被更新过,但是还没有写到内存里。

- 「已失效」状态,表示的是这个 Cache Block 里的数据已经失效了,不可以读取该状态的数据。

- 「独占」和「共享」状态都代表 Cache Block 里的数据是干净的,也就是说,这个时候 Cache Block 里的数据和内存里面的数据是一致性的。

- 「独占」和「共享」的差别在于,独占状态的时候,数据只存储在一个 CPU 核心的 Cache 里,而其他 CPU 核心的 Cache 没有该数据。这个时候,如果要向独占的 Cache 写数据,就可以直接自由地写入,而不需要通知其他 CPU 核心,因为只有你这有这个数据,就不存在缓存一致性的问题了,于是就可以随便操作该数据。

- 另外,在「独占」状态下的数据,如果有其他核心从内存读取了相同的数据到各自的 Cache ,那么这个时候,独占状态下的数据就会变成共享状态。

- 那么,「共享」状态代表着相同的数据在多个 CPU 核心的 Cache 里都有,所以当我们要更新 Cache 里面的数据的时候,不能直接修改,而是要先向所有的其他 CPU 核心广播一个请求,要求先把其他核心的 Cache 中对应的 Cache Line 标记为「无效」状态,然后再更新当前 Cache 里面的数据。

我们举个具体的例子来看看这四个状态的转换:

- 当 A 号 CPU 核心从内存读取变量 i 的值,数据被缓存在 A 号 CPU 核心自己的 Cache 里面,此时其他 CPU 核心的 Cache 没有缓存该数据,于是标记 Cache Line 状态为「独占」,此时其 Cache 中的数据与内存是一致的;

- 然后 B 号 CPU 核心也从内存读取了变量 i 的值,此时会发送消息给其他 CPU 核心,由于 A 号 CPU 核心已经缓存了该数据,所以会把数据返回给 B 号 CPU 核心。在这个时候, A 和 B 核心缓存了相同的数据,Cache Line 的状态就会变成「共享」,并且其 Cache 中的数据与内存也是一致的;

- 当 A 号 CPU 核心要修改 Cache 中 i 变量的值,发现数据对应的 Cache Line 的状态是共享状态,则要向所有的其他 CPU 核心广播一个请求,要求先把其他核心的 Cache 中对应的 Cache Line 标记为「无效」状态,然后 A 号 CPU 核心才更新 Cache 里面的数据,同时标记 Cache Line 为「已修改」状态,此时 Cache 中的数据就与内存不一致了。

- 如果 A 号 CPU 核心「继续」修改 Cache 中 i 变量的值,由于此时的 Cache Line 是「已修改」状态,因此不需要给其他 CPU 核心发送消息,直接更新数据即可。

- 如果 A 号 CPU 核心的 Cache 里的 i 变量对应的 Cache Line 要被「替换」,发现 Cache Line 状态是「已修改」状态,就会在替换前先把数据同步到内存。

说完了MESI协议,回到我们Example 8.5的那张图。具体缓存一致性在哪儿出问题了?

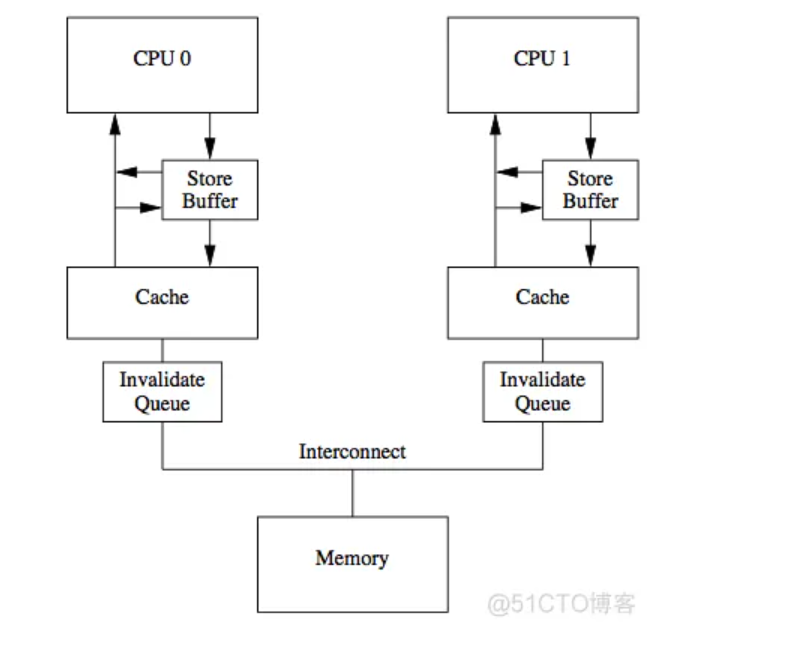

假设在cache line中状态为共享,在某个核更新数据时候会向总线发送已失效消息以获取数据的所有权,其他消息得到此消息后更新相应cache line状态为已失效,并回复Invalidate Acknowledge消息。显然我们可以看到这个过程非常的繁琐,如果每个操作生效前都需要这么多操作那也太低效了,所以引入了Invaildate queue和Store Buffer,为的就是异步执行指令,提高以上过程的效率。

因为写入到Invaildate queue和Store Buffer的数据并不会被立即执行。在执行写操作的核会把数据写入store buffer,后面异步的刷新到cache line,当然也会广播失效消息。而当另一个执行读操作的核收到这个失效消息时,会把消息写入自身的Invalidate Queue中,随后异步将cache line设为失效状态。写操作的核在读取的时候会扫描store buffer,而这个执行读操作的核在读取数据的时候并不会扫描Invaildate queue,这意味着读操作可能会在一段时间内读到老旧数据。

首先process 0和process 1把1放入到地址_x和_y的内存上,但是此时可能这些数据还存在自己的store buffer中,也就是对方都还没意识到数据已经发生修改,然后执行操作r2和r4的操作,此时就发生脏读,导致 r2 = 0 且 r4 = 0这种奇怪的事情发生。

- 也就是在processor 1把

y的值更改为1的时候,并没有直接写入内存。此时在processor 0眼里y还是0。所以r2就是0

https://mp.weixin.qq.com/s/Sz7QXx1h4sS7xWRUSP4ZCw

内存屏障

经过上面的总结,我们可以得出结论。内存屏障存在的意义是在一定程度上避免缓存一致性所带来的问题和指令重排。

在广义角度上,Intel有三种内存模型:

SFENCE,LFENCE和MFENCE指令提供了一种性能高效的方式,可确保在产生弱排序结果的例程和使用该数据的例程之间load和store内存排序。 这些指令的功能如下:

- SFENCE:序列化(动词,理解为串行化) 程序指令流中,在SFENCE指令之前发生的所有 store(写)操作,但不影响 load(读)操作。

- LFENCE:序列化 程序指令流中,在LFENCE指令之前发生的所有 load(读)操作,但不影响 store(写)操作。

- MFENCE:序列化 程序指令流中,在MFENCE指令之前发生的所有 store 和 load 操作。

当然,还有一些其他操作含有内存屏障的作用

- 总线上的内存映射设备和其他I / O设备通常对其I / O缓冲区的写入顺序敏感。可以使用I / O指令(IN和OUT指令)对此类访问施加强的写入顺序,如下所示。在执行I / O指令之前,处理器将等待程序中所有先前的指令完成,并等待所有缓冲的写入操作耗尽到内存。只有指令提取和页表遍历可以传递I / O指令。直到处理器确定I / O指令已完成,后续指令的执行才开始。

- 多处理器系统中的同步机制可能取决于强大的内存排序模型。在这里,程序可以使用诸如

XCHG指令或LOCK前缀之类的锁定指令,以确保原子地执行对存储器的读-修改-写操作。锁定操作通常类似于I / O操作,因为它们等待所有先前的指令完成并且等待所有缓冲的写操作排入内存。- 程序同步也可以通过序列化指令执行(请参见第8.3节)。这些指令通常用于关键过程或任务边界,以在跳到新的代码段或上下文切换之前强制完成所有先前的指令。像I / O和锁定指令一样,处理器在执行序列化指令之前要等到所有先前的指令都已完成并且所有缓冲的写操作都已排入内存为止。

请注意,与CPUID指令相比,SFENCE,LFENCE和MFENCE指令提供了一种更有效的控制内存顺序的方法。

从上面,我们可以看出:内存屏障,带Lock或XCHG前缀的指令,I/O操作都会把数据载入内存,自然就不存在前面我们提到的脏读问题了。

我们一直以来提到的指令重排指的是运行时排序。编译器也会导致指令重排。这里更多的讨论见这里

内存模型(内存序)

我们前面提到了程序运行时的指令重排,内存模型其实规定的就是这些指令的重排哪些排列顺序是正确的,也就是指明在特定要求下,哪些是可以出现的,哪些是不可以出现的。

事实上对于内存模型的描述我们可以从两个方面来看,一个是硬件角度的内存模型,也就是厂商给我们提供了怎样的一种一致性保证;还有一种是软件级别的内存模型,其实说直白一点就是一些高级语言给程序员提供的一致性保证,显然此时我们可以不必费尽心机去考虑代码如何适配不同的机器。

比如X86的强模型和ARM的弱模型,如果仅仅依靠硬件提供的内存屏障这个代码将非常难写, 因为不同硬件本身的提供的内存模型是不一样的,甚至有时操作也不相同。但是如果基于软件级别的内存模型,比如使用C++的内存模型(手段为内存序),那么编译器就会帮我们自动去适配不同的机器,因为这是语言保证的。

英特尔酷睿2双核,英特尔凌动,英特尔酷睿双核,奔腾4和P6家族处理器还使用处理器排序的内存排序模型,该模型可以进一步定义为“使用存储缓冲区转发进行写入排序”。 该模型的特征如下。 在用于定义为WB的内存区域的单处理器系统中,内存排序模型遵循以下原则(请注意,单处理器和多处理器系统的内存排序原则是从在以下环境中执行软件的角度编写的。其中术语“处理器”是指逻辑处理器。例如,支持多核和/或Intel超线程技术的物理处理器被视为多处理器系统。)

读操作之间无法排序

写操作不能和旧的读操作之间排序

写操作与写操作之间除了以下情况以外不能重新排序:

带有non-temporal move指令的流存储(写入)(MOVNTI, MOVNTQ, MOVNTDQ, MOVNTPS, 和 MOVNTPD)

串操作

- 执行CLFLUSH指令不能重新排序对存储器的写操作。 可以通过执行CLFLUSHOPT指令的执行来重新排序写操作,该指令将刷新除正在写入的高速缓存行以外的其他高速缓存行。 CLFLUSH指令的执行不会相互重新排序。 访问不同缓存行的CLFLUSHOPT的执行可能会相互重新排序。 CLFLUSHOPT的执行可以与访问不同缓存行的CLFLUSH的执行重新排序。

- 读取可能会与不同地址的较旧写入重新排序,但对不同地址的较旧写入则不会重新排序。(store load重排)

- 读写操作不能与IO操作,带LOCK的指令,序列化指令重排序。(上面曾提到过这个问题)

- 读操作不能越过前面的LFENCE和MFENCE操作

- 写操作和CLFLUSH和CLFLUSHOPT的执行不能越过前面的LFENCE,SFENCE和MFENCE指令。

- LFENCE不能越过前面的读操作

- SFENCE不能越过前面的写操作

- MFENCE不能越过前面的读写操作以及CLFLUSH和CLFLUSHOPT的执行。

https://zhuanlan.zhihu.com/p/269221065?utm_id=0

https://blog.51cto.com/u_15703183/5464436

https://blog.csdn.net/qq_22642239/article/details/114022306

https://redrain.blog.csdn.net/article/details/111327141

C++中的内存序—-三(四)种模型和六种枚举值

std::memory_order指定内存访问,包括常规的非原子内存访问,如何围绕原子操作排序。在没有任何制约的多处理器系统上,多个线程同时读或写数个变量时,一个线程能观测到变量值更改的顺序不同于另一个线程写它们的顺序。其实,更改的顺序甚至能在多个读取线程间相异。一些类似的效果还能在单处理器系统上出现,因为内存模型允许编译器变换。

注意,其实内存序并不能简单描述成为禁止某某操作排到某某操作后面。因为就算单纯禁止重排,也有可能发生我们提过的缓存一致性问题。所以说,应该用可见性这个词。可见性这个词包含了描述重排和缓存一致性的情况。所以说,我们说某某操作现在是可见的,表明了确实我们保证操作正确。也就是不仅正确处理了重排,也正确处理了缓存一致性问题。

顺序一致(sequentially consistent ordering)

memory_order_seq_cst

C++使用这个做为操作原子变量的默认值。可以直接看文档。

- Load/store/RMW操作都可以使用该枚举值,用于

load operation(原子读操作)的时候有acquire operation的特性,用于store operation(原子写操作)的时候有release operation的特性, 用于read-modify-write operation(RMW)的时候有acq_rel operation的特性,且所有操作都相当于一个双向屏障,前后语句都不能跨越该操作进行重排。并且所有线程的语句都以全局的内存修改顺序为参照。 看起来,这个和

memory_order_acq_rel差不多啊?并不是。这种内存序列会对拥有此标签的内存操作建立一个单独全序。memory_order_seq_cst比memory_order_acq_rel更强,memory_order_acq_rel的顺序保障,是要基于同一个原子变量的,也就是说,在这个原子变量之前的读写,不能重排到这个原子变量之后,同时这个原子变量之后的读写,也不能重排到这个原子变量之前。但是,如果两个线程基于memory_order_acq_rel使用了两个不同的原子变量x1, x2,那在x1之前的读写,重排到x2之后,是完全可能的,在x1之后的读写,重排到x2之前,也是被允许的。然而,如果两个原子变量x1,x2,是基于memory_order_seq_cst在操作,那么即使是x1之前的读写,也不能被重排到x2之后,x1之后的读写,也不能重排到x2之前,也就说,如果都用memory_order_seq_cst,那么程序代码顺序(Program Order)就将会是你在多个线程上都实际观察到的顺序(Observed Order)- 简而言之: 在这个模型下, 所有线程看到的所有操作都有一个一致的顺序, 即使这些操作可能针对不同的变量, 运行在不同的线程. 2.1 节中我们介绍了修改顺序 (modification order), 即单一变量的修改顺序在所有线程看来都是一致的. Sequencial consistent 则将这种一致性扩展到了所有变量. 例如

1

2

3

4

5

6

7

8

9

std::atomic<bool> x{false}, y{false};

void thread1() {

x.store(true, std::memory_order_seq_cst); // (1)

}

void thread2() {

y.store(true, std::memory_order_seq_cst); // (2)

}

thread1 和 thread2 分别修改原子变量 x 和 y. 运行过程中, 有可能先执行 (1) 再执行 (2), 也有可能先执行 (2) 后执行 (1). 但无论如何, 所有线程中看到的顺序都是一致的. 因此如果我们这样测试这段代码:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

std::atomic<int> z{0};

void read_x_then_y() {

while (!x.load(std::memory_order_seq_cst)); // (3)

if (y.load(std::memory_order_seq_cst)) ++z; // (4)

}

void read_y_then_x() {

while (!y.load(std::memory_order_seq_cst)); // (5)

if (x.load(std::memory_order_seq_cst)) ++z; // (6)

}

int main() {

std::thread a(thread1), b(thread2), c(read_x_then_y), d(read_y_then_x);

a.join(), b.join(), c.join(), d.join();

assert(z.load() != 0); // (7)

}

(7) 处的断言永远不会失败. 因为 x 和 y 的修改顺序是全局一致的, 如果先执行 (1) 后执行 (2), 则 read_y_then_x 中循环 (5) 退出时, 能保证 y 为 true, 此时 x 也必然为 true, 因此 (6) 会被执行; 同理, 如果先执行 (2) 后执行 (1), 则循环 (3) 退出时 y 也必然为 true, 因此 (4) 会被执行. 无论如何, z 最终都不会等于 0.

所有线程会以相同的顺序观察到这两个操作的执行顺序. 所以如果某个线程看到thread1先执行, 那么其余所有线程都会看到thread1先执行. 然而,这并不意味着线程1和线程2的操作之间有任何特定的顺序。具体来说,x.store(true) 和 y.store(true) 的顺序在不同的线程之间是有序的,但在同一线程中没有保证它们的相对顺序。

Sequencial consistent 可以实现 synchronizes-with 的关系. 如果一个 memory_order_seq_cst 的 load 操作在某个原子变量上读到了一个 memory_order_seq_cst 的 store 操作在这个原子变量中写入的值, 则 store 操作 “synchronizes-with” load 操作. 在上面的例子中, 有 (1) “synchronizes-with” (3) 和 (2) “synchronizes-with” (5).

顺序一致模型有一个最大的问题:它的性能差。我们很多时候并不需要对整体的原子操作进行排序。一般都是局部有序。注意到锁和内存屏障的区别。锁一般来说都是局部的,也就是针对某一个区域加锁解锁。但是不同的锁之间往往是没有顺序的。也就是说,锁更像acquire--release模型,而不是seq_cst模型。

获取发布 (release-acquire/consume ordering)

memory_order_consume

类似于

memory_order_acquire,也是用于load操作,但更为宽松。针对于该load操作,不允许load之后的有关联(依赖)的操作重排到load之前。memory_order_consume适用于load operation(原子读操作),对于采用此内存序的load operation,我们可以称为consume operation(consume原子读操作),设有一个原子变量M上的consume operation(consume原子读操作),对周围内存序的影响是:当前线程中该

consume operation(consume原子读操作)后的依赖该consume operation(consume原子读操作)读取的值的写入或读取操作不能被重排到该consume operation(consume原子读操作)前,其他线程中所有对M的release operation(原子写操作)及其之前的对数据依赖变量的写入都对当前线程从该consume operation(consume原子读操作)开始往后的操作可见相比较于下面讲的

memory_order_acquire,memory_order_consume只是阻止了之后有依赖关系的重排。绝大部分平台上,这个内存序只会影响到编译器优化,依赖于dependency chain。但实际上很多编译器都没有正确地实现consume,导致等同于acquire。见下图,如果我们把

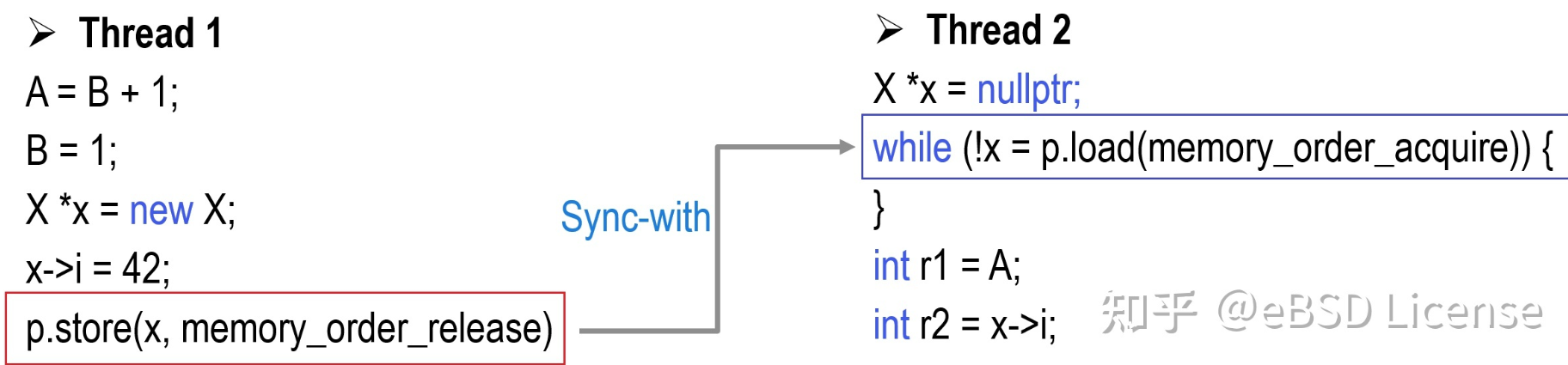

memory_order_acquire换成了memory_order_consume,那么将只有int r2 = x->i是有效的,因为其读取的值依赖原子变量p,但int r1 = A并不能保证读到线程1写入到A的值,因为A值并不依赖p。

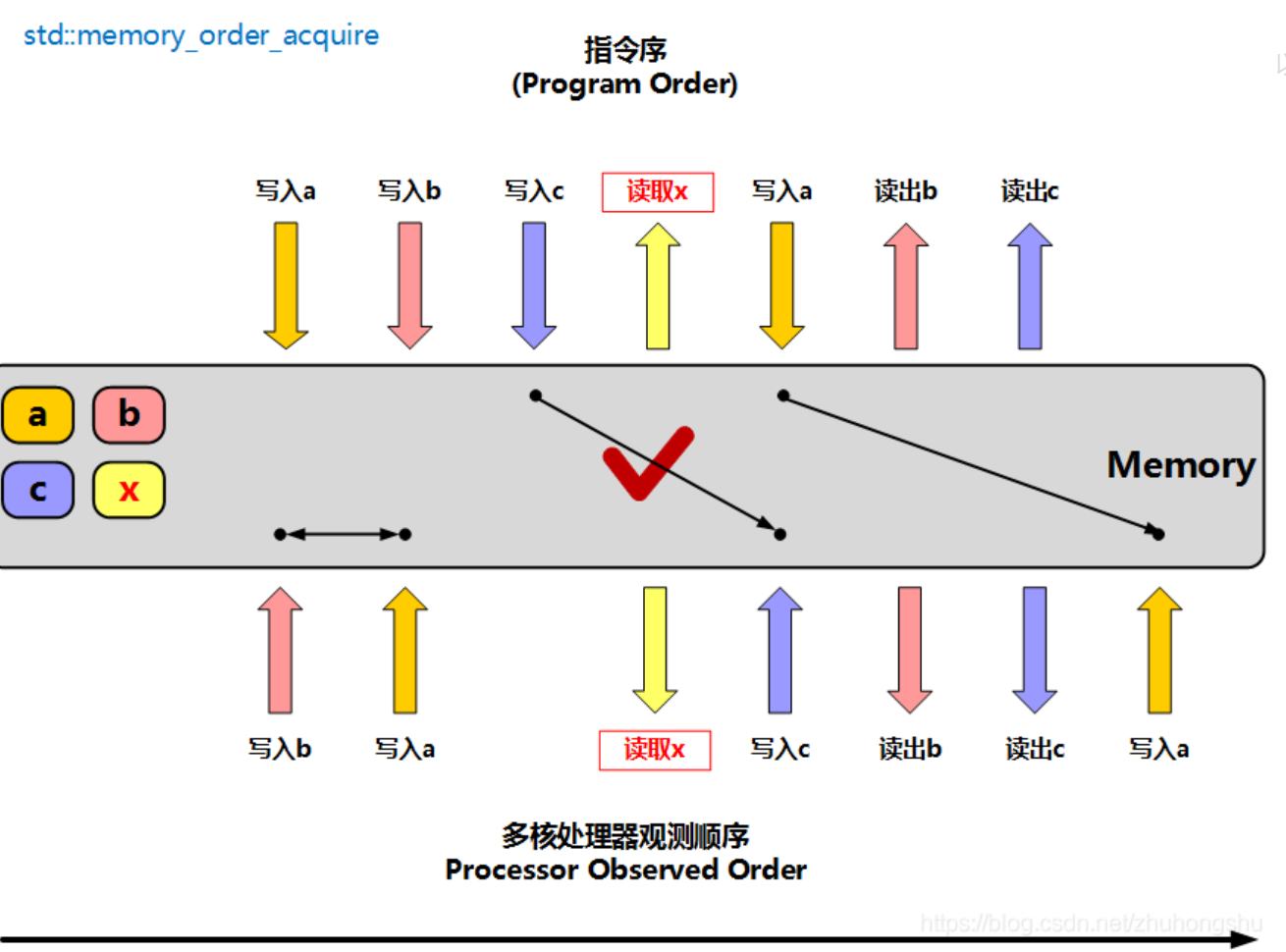

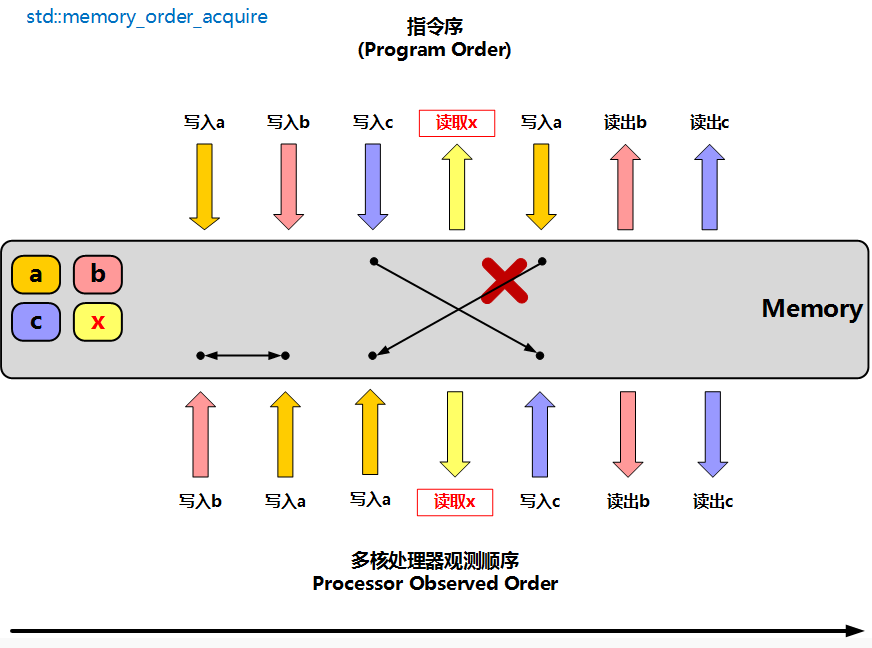

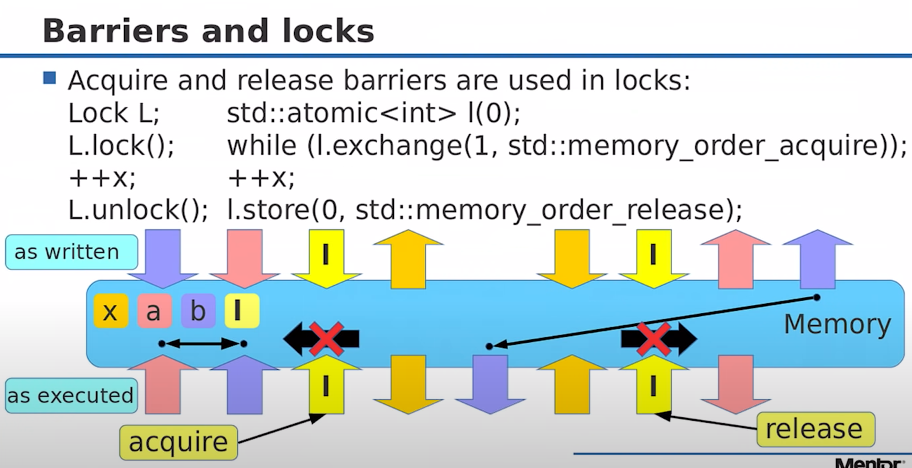

memory_order_acquire —- 理解为 acquire lock

- 针对于该

load操作,不允许load之后的操作重排到load之前。 - 说人话就是:单向加载内存屏障,表示线程中的读写指令不能重排到此读屏障指令之前,另一个执行写原子变量的线程里写操作之前的变量,可以被此线程 读取。

- 理解为

lock()。也就是lock之后的代码不能放到lock之前。理解为我们acquire其他线程publish的操作。

- 理解为

memory_order_acquire适用于load operation(原子读操作),对于采用此内存序的load operation(原子读操作),我们可以称为acquire operation,设有一个原子变量M上的acquire operation(原子读操作),对周围内存序的影响是:- 当前线程中该

acquire operation(原子读操作)后的任何内存读写操作都不能被重排到该acquire operation(原子读操作)前。 - 结合下面的

memory_order_release我们能推导出从而会有其他线程中所有对M的release operation(原子写操作)及其之前的写入都对当前线程从该acquire operation(原子读操作)开始往后的操作可见。

- 当前线程中该

此时在一个线程上执行时,读取x的内存屏障操作之前的指令允许重排到x之后,但是读取x之后的指令不会被重排到x前面。

实际上memory_order_release用于写入、memory_order_acquire用于读取,他们是成对使用:线程A使用memory_order_release写原子变量x,线程B使用memory_order_acquire读原子变量x。线程A写x之前的操作,都可以被线程B在读x之后看到

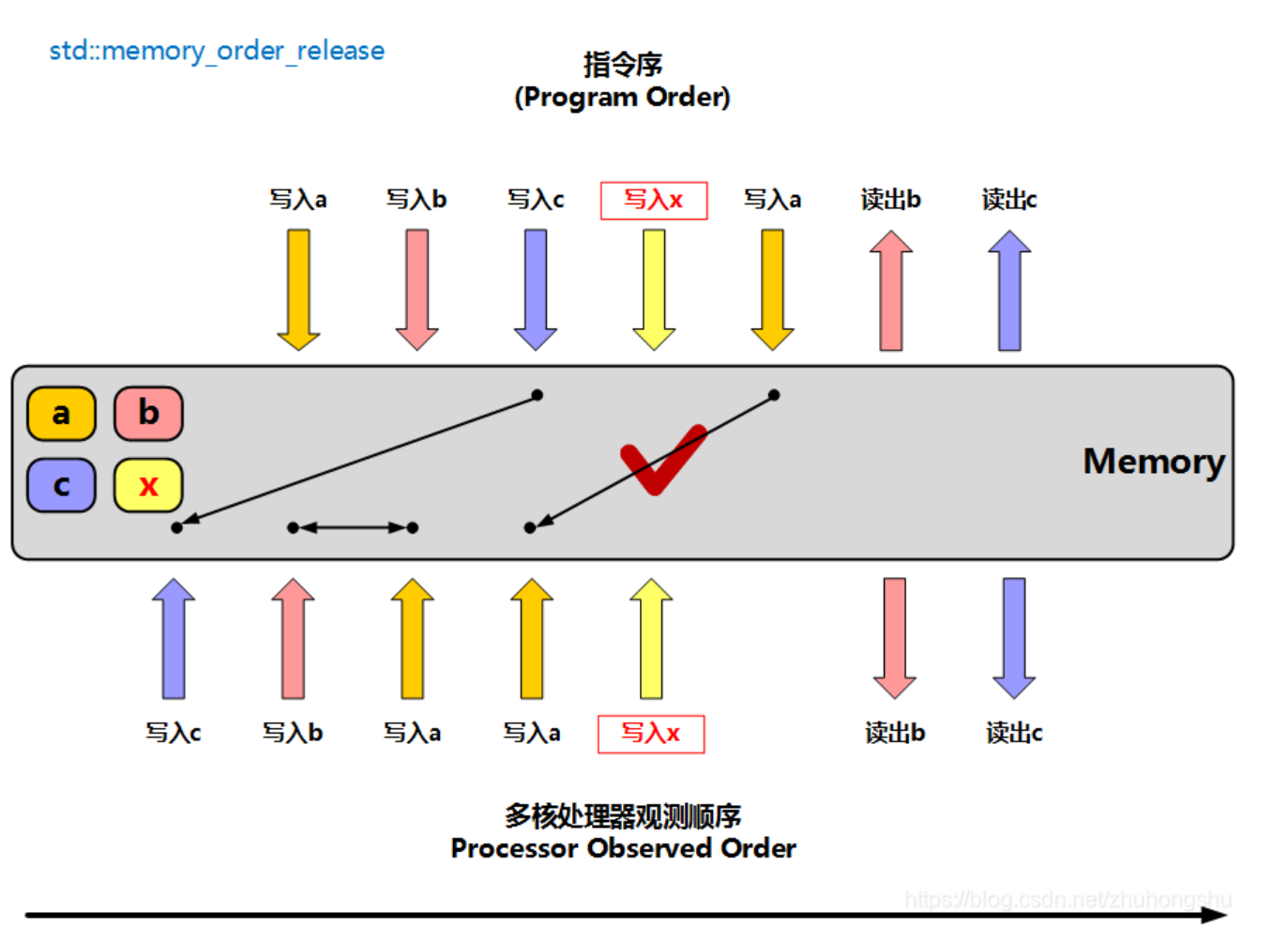

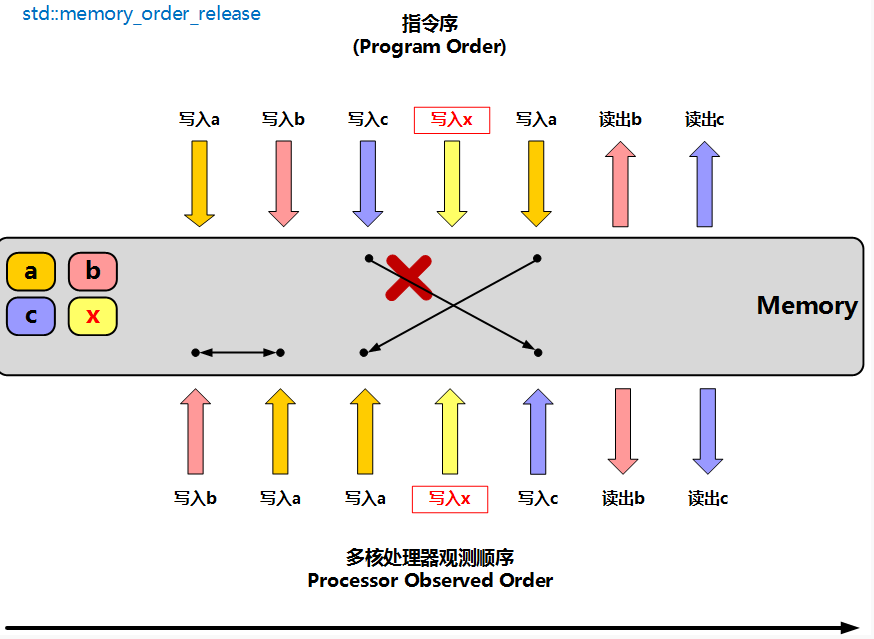

memory_order_release —- 理解为 release unlock

- 针对于该

store操作,不允许store之前的操作重排到store之后。 - 说人话就是:单向释放内存屏障,表示线程中的读写指令不能重排到此写原子变量指令之后。另一个执行读原子变量的线程,可以正确读取指令之前的变量

- 理解为

unlock()。也就是unlock前面的代码不能放到unlock后面。理解为我们把我们对内存的更改 release掉。也就是publish给其他线程 memory_order_release适用于store operation(原子写操作),对于采用此内存序的写入操作,我们可以称为release operation,设有一个原子变量M上的release operation(写入操作),对周围内存序的影响是:该

release operation(写入操作)前的内存读写都不能重排到该release operation(写入操作)之后。(该store操作,不允许store之前的操作重排到store之后。)结合memory_order_acquire的左右从而有:- 当前线程截止到该

release operation(原子写操作)的所有内存写入都对另外线程对M的acquire operation(原子读操作)以及之后的内存操作可见,这就是release acquire语义。 - 当前线程截止到该operation的所有M所依赖的内存写入都对另外线程对M的

consume operation以及之后的内存操作可见,这就是release consume语义。

- 当前线程截止到该

- 理解为

此时在一个线程上执行时,写入x的内存屏障操作之后的指令允许重排到x之前,但是写入x之前的指令不会被重排到x后面。 不过写入x指令前后的那些指令的顺序是允许重排的。所以使用memory_order_release屏障后,可以保障另一个线程在执行了读取x操作之后,读取a、b、c的值是正确的,因为a、b、c的写入操作一定不会被重排到x操作之后

memory_order_acq_rel

- 双向的”加载-释放”内存屏障。

- 多用于CAS操作。比如

compare_exchange_weak/strong,fetch_add/sub/...等 - 用于RMW(read-modify-write)原子操作,RMW操作前后的语句都不允许跨越该操作而重排。该操作相当于兼具load(acquire)和store(release),可以看作由这两个操作组成,但是整体上是原子的。

memory_order_acq_rel适用于read-modify-write operation(RMW操作),对于采用此内存序的read-modify-write operation,我们可以称为acq_rel operation,既属于acquire operation也是release operation. 设有一个原子变量M上的acq_rel operation:自然的,因为同时具有两种属性,所以该acq_rel operation之前的内存读写都不能重排到该acq_rel operation之后,该acq_rel operation之后的内存读写都不能重排到该acq_rel operation之前. 其他线程中所有对M的release operation(写入操作)及其之前的写入都对当前线程从该acq_rel operation开始的操作可见,并且截止到该acq_rel operation的所有内存写入都对另外线程对M的acquire operation(原子读操作)以及之后的内存操作可见。- 注意,针对内存屏障,多线程之间必须要使用的是同一个原子变量。因为是使用这一个原子变量的值进行同步的。这里和顺序一致模型有区别

release-acquire 可以实现 synchronizes-with 的关系. 如果一个 acquire 操作在同一个原子变量上读取到了一个 release 操作写入的值, 则这个 release 操作 “synchronizes-with” 这个 acquire 操作. 我们来看一个例子:

1

2

3

4

5

6

7

8

9

10

11

std::atomic<bool> x{false}, y{false};

void thread1() {

x.store(true, std::memory_order_relaxed); // (1)

y.store(true, std::memory_order_release); // (2)

}

void thread2() {

while (!y.load(std::memory_order_acquire)); // (3)

assert(x.load(std::memory_order_relaxed)); // (4)

}

在上面的例子中, 语句 (2) 使用 memory_order_release 在 y 中写入 true, 语句 (3) 中使用 memory_order_acquire 从 y 中读取值. 循环 (3) 退出时, 它已经读取到了 y 的值为 true, 也就是读取到了操作 (2) 中写入的值. 因此有 (2) “synchronizes-with” (3). 所以我们可以推导出:

- 因为 (2) “synchronizes-with” (3) 且 (3) “sequenced-before” (4), 所以 (2) “inter-thread happens-before” (4);

- 因为 (1) “sequenced-before” (2) 且 (2) “inter-thread happens-before” (4), 所以 (1) “inter-thread happens-before” (4);

所以 (1) “happens-before” (4). 因此 (4) 能读取到 (1) 中写入的值, 断言永远不会失败. 即使 (1) 和 (4) 用的是 memory_order_relaxed.

我们提到 sequencial consistent 模型可以实现 synchronizes-with 关系. 事实上, 内存顺序为 memory_order_seq_cst 的 load 操作和 store 操作可以分别视为 acquire 操作和 release 操作. 因此对于两个指定了 memory_order_seq_cst 的 store 操作和 load 操作, 如果后者读到了前者写入的值, 则前者 “synchronizes-with” 后者.

为了实现 synchronizes-with 关系, acquire 操作和 release 操作应该成对出现. 如果 memory_order_acquire 的 load 读到了 memory_order_relaxed 的 store 写入的值, 或者 memory_order_relaxed 的 load 读到了 memory_order_release 的 store 写入的值, 都不能实现 synchronizes-with 的关系.

虽然 sequencial consistent 顺序一致模型能够像 release-acquire 一样实现同步, 但是反过来 release-acquire 模型不能像 sequencial consistent 一样提供全局顺序一致性. 如果将顺序一致一节例子中的 memory_order_seq_cst 换成 memory_order_acquire 和 memory_order_release

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

void thread1() {

x.store(true, std::memory_order_release); // (1)

}

void thread2() {

y.store(true, std::memory_order_release); // (2)

}

void read_x_then_y() {

while (!x.load(std::memory_order_acquire)); // (3)

if (y.load(std::memory_order_acquire)) ++z; // (4)

}

void read_y_then_x() {

while (!y.load(std::memory_order_acquire)); // (5)

if (x.load(std::memory_order_acquire)) ++z; // (6)

}

则最终不能保证 z 不为 0. 在同一次运行中, read_x_then_y 有可能看到先 (1) 后 (2), 而 read_y_then_x 有可能看到先 (2) 后 (1). 这样有可能 (4) 和 (6) 的 load 的结果都为 false, 导致最后 z 仍然为 0.

release-acquire 的开销比 sequencial consistent 小. 在 x86 架构下, memory_order_acquire 和 memory_order_release 的操作不会产生任何其他的指令, 只会影响编译器的优化: 任何指令都不能重排到 acquire 操作的前面, 且不能重排到 release 操作的后面; 否则会违反 release-acquire 的语义. 因此很多需要实现 synchronizes-with 关系的场景都会使用 release-acquire

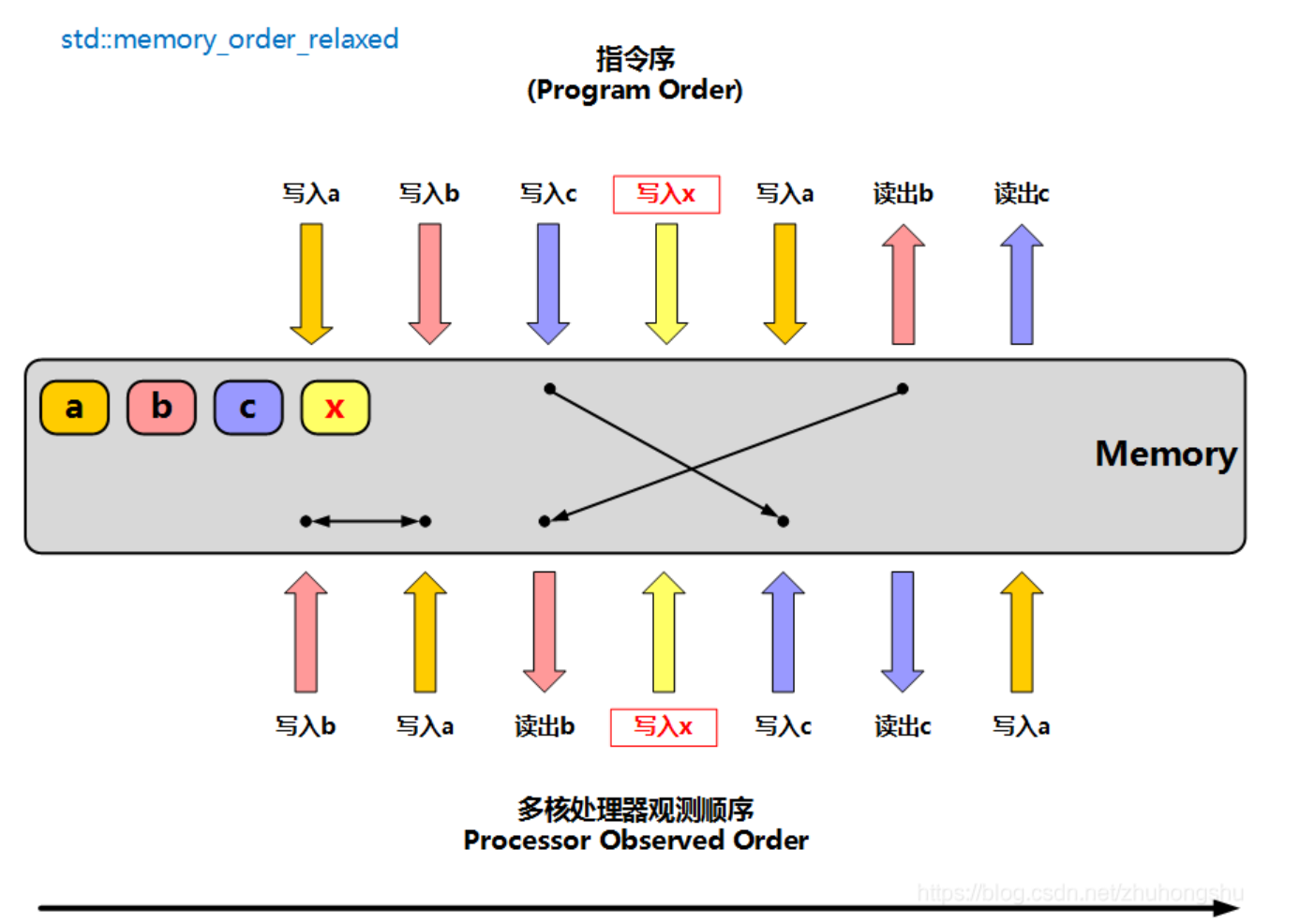

宽松(relaxed ordering )

memory_order_relaxed

memory_order_relaxed 可以用于 store, load 和 read-modify-write 操作

- 这种模型下, 只能保证操作的原子性和修改顺序 (modification order) 一致性, 无法实现 synchronizes-with 的关系. 对于其它读写操作没有任何同步和重排的限制,仅要求保证读写的原子性和内存一致性。除此之外,不提供任何跨线程的同步。

- 一般应用于计数器场景

1

2

3

4

5

6

// Thread 1:

r1 = y.load(std::memory_order_relaxed); // A

x.store(r1, std::memory_order_relaxed); // B

// Thread 2:

r2 = x.load(std::memory_order_relaxed); // C

y.store(42, std::memory_order_relaxed); // D

执行完上面的程序,可能出现r1 == r2 == 42。理解这一点并不难,因为编译器允许调整 C 和 D 的执行顺序。如果程序的执行顺序是 D -> A -> B -> C,那么就会出现r1 == r2 == 42。

1

2

3

4

5

6

std::atomic<bool> x{false}, y{false};

void thread1() {

x.store(true, std::memory_order_relaxed); // (1)

y.store(true, std::memory_order_relaxed); // (2)

}

thread1 对不同的变量执行 store 操作. 那么在某些线程看来, 有可能是 x 先变为 true, y 后变为 true; 另一些线程看来, 又有可能是 y 先变为 true, x 后变为 true. 如果这样测试这段代码:

1

2

3

4

void thread2() {

while (!y.load(std::memory_order_relaxed)); // (3)

assert(x.load()); // (4)

}

(4) 处的断言就有可能失败. 因为 (2) 与 (3) 之间没有 synchronizes-with 的关系, 所以就不能保证 (1) “happens-before” (4). 因此 (4) 就有可能读到 false.

- 图中x代表atomic类型变量。此时在一个线程上执行时,在这个线程认为不影响最终结果的前提下,实际执行时指令可能完全是乱的。写入a、写入b的操作实际执行时可能是调换了;写入c的操作可能实际在写入x之后执行;读出b的操作实际在写入x之前执行

Relaxed 顺序模型的开销很小. 在 x86 架构下, memory_order_relaxed 的操作不会产生任何其他的指令, 只会影响编译器优化, 确保操作是原子的. Relaxed 模型可以用在一些不需要线程同步的场景, 但是使用时要小心. 例如 std::shared_ptr 增加引用计数时用的就是 memory_order_relaxed, 因为不需要同步; 但是减小应用计数不能用它, 因为需要与析构操作同步

小的总结

| 操作 | 有效的Memory order枚举值 | 备注 |

|---|---|---|

| Load | memory_order_relaxed, memory_order_consume, memory_order_acquire, memory_order_seq_cst | 其它枚举值不合法, MS STL的实现是将其当作memory_order_seq_cst处理 |

| Store | memory_order_relaxed, memory_order_release, memory_order_seq_cst | 同上 |

| read-modify-write | memory_order_relaxed, memory_order_consume, memory_order_acquire, memory_order_release, memory_order_acq_rel, memory_order_seq_cst |

memory_order_relaxed: 最宽松的内存顺序, 只保证操作的原子性和修改顺序 (modification order).memory_order_acquire,memory_order_release和memory_order_acq_rel: 实现 acquire 操作和 release 操作, 如果 acquire 操作读到了 release 操作写入的值, 或其 release sequence 写入的值, 则构成 synchronizes-with 关系, 进而可以推导出 happens-before 的关系.memory_order_consume: 实现 consume 操作, 能实现数据依赖相关的同步关系. 如果 consume 操作读到了 release 操作写入的值, 或其 release sequence 写入的值, 则构成 dependency-ordered before 的关系, 对于有数据依赖的操作可以进而推导出 happens-before 的关系.memory_order_seq_cst: 加强版的 acquire-release 模型, 除了可以实现 synchronizes-with 关系, 还保证全局顺序一致.

参考资料:https://zhuanlan.zhihu.com/p/382372072?utm_id=0

https://blog.csdn.net/wxj1992/category_11580766.html

https://lday.me/2017/12/02/0018_cpp_atomic_summary/

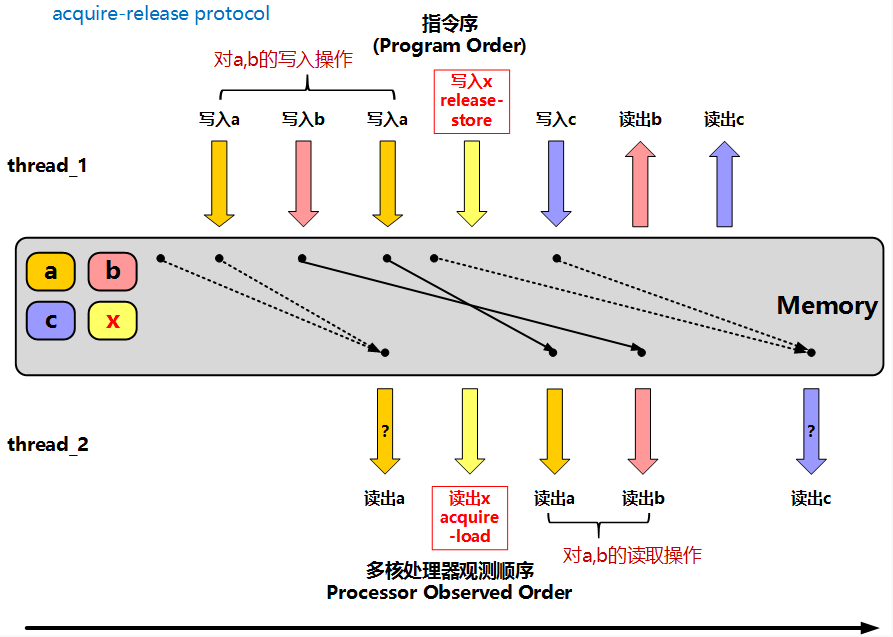

memory_order_acquire和memory_order_release 如何搭配使用

往往memory_order_acquire和memory_order_release是配合着一起使用的:

- 线程1使用

memory_order_release写入原子变量x - 线程2使用

memory_order_acquire读出原子变量x

所有在线程1上,在写入x之前的写入操作,都将在线程2上,在读出x之后,被看到。使用单向“加载”+单向“释放”协议的场景往往是:

- 线程1,写入一些实际数据,接着通过将原子变量x设置为某个值

A(通过使用memory_order_release写入原子变量x)来“发布”这些数据。 - 线程2,通过读取并判断x已被设置为

A(通过使用memory_order_acquire来读取原子变量x),进而读取线程1实际“发布”的那些数据

必须操作的是同一个原子变量。

如上图所示,thread_1在release写入x(值:A)之前,写入了待发布的a,b的数据,而thread_2,将在acquire读出x且为A之后,将读到thread_1发布的a,b的数据。同时,我们可以注意到,在thread_2上,在acquire读出x之前,如果对a进行读操作,我们是无法确认读到的a一定会thread_1在之前最后写入的a,这里的顺序是不会被保证的,重排是被允许的。同时,在之后,读取c,读到的是否为thread_1最后写入的c,也是不确定的,因为,在x写入之后,thread_1上又出现了一次写入,而如果在此之前,还有一次写入, 这两次写入之间,是不存在限制,可能会被重排的。

thread_1上有了release_store,对于a,b的写入就一定会在x的改变之前,在thread_2上,就不会出现类似读出c,的不确定性。thread_2上有了acquire_load,右侧的读出a,就不会被重排读到左侧,而左侧读出a的不确定性,也不存在。thread_1卡住的是:对于数据a,b的写入不能排到x的写入之后,thread_2卡住的,是对于数据a,b的读取,不能排到读取x之前,这样,就保证了数据a,b,与”信号量”x,之间,在thread_1, thread_2上的同步关系。

Release sequences 释放序列

到目前为止我们看到的, 无论是 sequencial consistent 还是 release-acquire, 要想实现 synchronizes-with 的关系, acquire 操作必须在同一个原子变量上读到 release 操作的写入的值. 如果 acquire 操作没有读到 release 操作写入的值, 那么它俩之间通常没有 synchronizes-with 的关系. 例如

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

std::atomic<int> x{0}, y{0};

void thread1() {

x.store(1, std::memory_order_relaxed); // (1)

y.store(1, std::memory_order_release); // (2)

}

void thread2() {

y.store(2, std::memory_order_release); // (3)

}

void thread3() {

while (!y.load(std::memory_order_acquire)); // (4)

assert(x.load(std::memory_order_relaxed) == 1); // (5)

}

上面的例子中, 只要 y 的值非 0 循环 (4) 就会退出. 当它退出时, 有可能读到 (2) 写入的值, 也有可能读到 (3) 写入的值. 如果是后者, 则只能保证 (3) “synchronizes-with” (4), 不能保证与 (2) 与 (4) 之间有同步关系. 因此 (5) 处的断言就有可能失败.

但并不是只有在 acquire 操作读取到 release 操作写入的值时才能构成 synchronizes-with 关系. 为了说这种情况, 我们需要引入 release sequence 这个概念.

针对一个原子变量 M 的 release 操作 A 完成后, 接下来 M 上可能还会有一连串的其他操作. 如果这一连串操作是由

- 同一线程上的写操作, 或者

- 任意线程上的 read-modify-write 操作

这两种构成的, 则称这一连串的操作为以 release 操作 A 为首的 release sequence. 这里的写操作和 read-modify-write 操作可以使用任意内存顺序.

如果一个 acquire 操作在同一个原子变量上读到了一个 release 操作写入的值, 或者读到了以这个 release 操作为首的 release sequence 写入的值, 那么这个 release 操作 “synchronizes-with” 这个 acquire 操作. 我们来看个例子

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

std::vector<int> data;

std::atomic<int> flag{0};

void thread1() {

data.push_back(42); // (1)

flag.store(1, std::memory_order_release); // (2)

}

void thread2() {

int expected = 1;

while (!flag.compare_exchange_strong(expected, 2, std::memory_order_relaxed)) // (3) 注意此处使用了宽松

expected = 1;

}

void thread3() {

while (flag.load(std::memory_order_acquire) < 2); // (4)

assert(data.at(0) == 42); // (5)

}

上面的例子中, (3) 处的 compare_exchange_strong 是一种 RMW 操作, 它判断原子变量的值是否与期望的值 (第一个参数) 相等, 如果相等则将原子变量设置成目标值 (第二个参数) 并返回 true, 否则将第一个参数 (引用传递) 设置成原子变量当前值并返回 false. 操作 (3) 会一直循环检查, 当 flag 当值为 1 时, 将其替换成 2. 所以 (3) 属于 (2) 的 release sequence. 而循环 (4) 退出时, 它已经读到了 (3) 写入的值, 也就是 release 操作 (2) 为首的 release sequence 写入的值. 所以有 (2) “synchronizes-with” (4). 因此 (1) “happens-before” (5), (5) 处的断言不会失败.

注意 (3) 处的 compare_exchange_strong 的内存顺序是 memory_order_relaxed, 所以 (2) 与 (3) 并不构成 synchronizes-with 的关系. 也就是说, 当循环 (3) 退出时, 并不能保证 thread2 能读到 data.at(0) 为 42. 但是 (3) 属于 (2) 的 release sequence, 当 (4) 以 memory_order_acquire 的内存顺序读到 (2) 的 release sequence 写入的值时, 可以与 (2) 构成 synchronizes-with 的关系

注意, 这种只是一种概念. 依赖于代码的正确性. 同时, 我们说 “当循环 (3) 退出时, 并不能保证 thread2 能读到 data.at(0) 为 42”的原因是 这个插入操作由于缓存一致性的原因, 并不保证被刷新到thread2的cache内. 尽管从逻辑上讲, 当flag从1变为2的时候, 写入操作已经发生了, 但是这个时候这个写入并不一定保证对thread2可见. 当然了, 假设这个原子变量和写入数据在一个cache line中, 这个操作可能对thread2是可见的

如何理解内存序和锁之间的联系?

多线程编程,临界区是一个很重要的概念。我们对此再做进一步的认识。

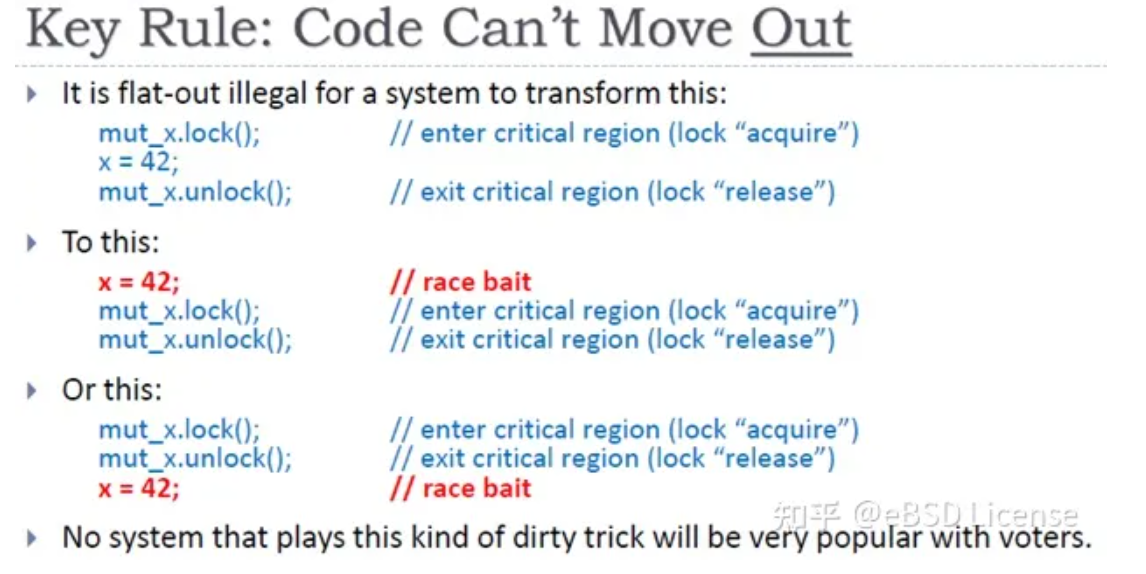

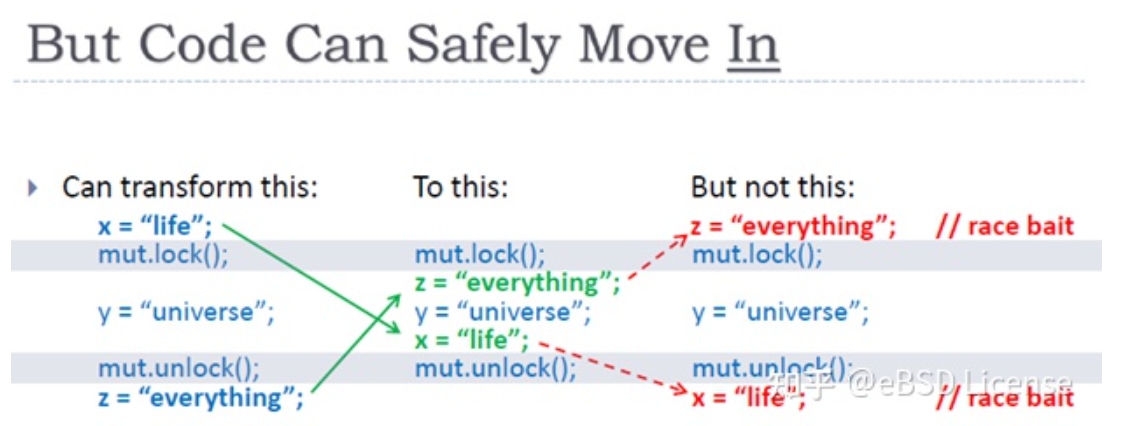

对于临界区区内的语句,显而易见,我们不能将其移出临界区,如下图所示,编译器和CPU都不会做这种移出临界区的优化:

但我们可以将临界区区外的代码移进来,如下图所示

从上面两张图我们可以看出,lock和unlock可以看作两个单方向的屏障,lock对应的屏障,只允许代码往下方向移动,而`unlock则只允许上方向移动。

所以我们是不是发现:memory_order_acquire类似lock,memory_order_release类似unlock,这两个都是单方向的屏障(One-way Barriers: acquire barrier, release barrier)。

所以借助内存屏障+原子变量,在比互斥锁更底层的层面,我们也能实现线程间同步。比如下图的例子:

p原子变量,当线程2看到p为非空时,后续的r1 = A语句可以看到线程1对A的写操作结果。这是因为线程1对p的store操作Synchronizes-with线程2对p的load操作,这样加之Happens-before关系,我们实现了线程间同步。值得一提的是,线程1中,A=B+1Happens-before B = 1,但B = 1可能先执行,但线程1对A的写操作的结果,依旧能正确地被线程2中int r1 = A语句读取。

换句话说,我们利用了memory_order_release,使得针对A和B的写入一定会发生在写入原子变量p之前。我们利用了memory_order_acquire使得针对A和x的读取一定发生在读取原子变量p之前。

有人也许会问,用非原子变量难道不能实现Synchronizes-with关系?首先,非原子变量,显然不能被多个线程同时读写,再者,其无法提供内存屏障,不要忘了前文重排的例子,试想,若线程1中A和B的写入操作被重排到了p.store的后面,且即使替换p.store的非原子变量操作在多线程下可以正确执行,但此时int r1 = A能读取到正确的值吗?

这里所谓的指定内存序,指的是对执行语句所在的线程内部的限制,也就是只影响一个cpu核心,但是这些对单线程内部的限制组合起来就能实现多线程之间数据同步的效果,

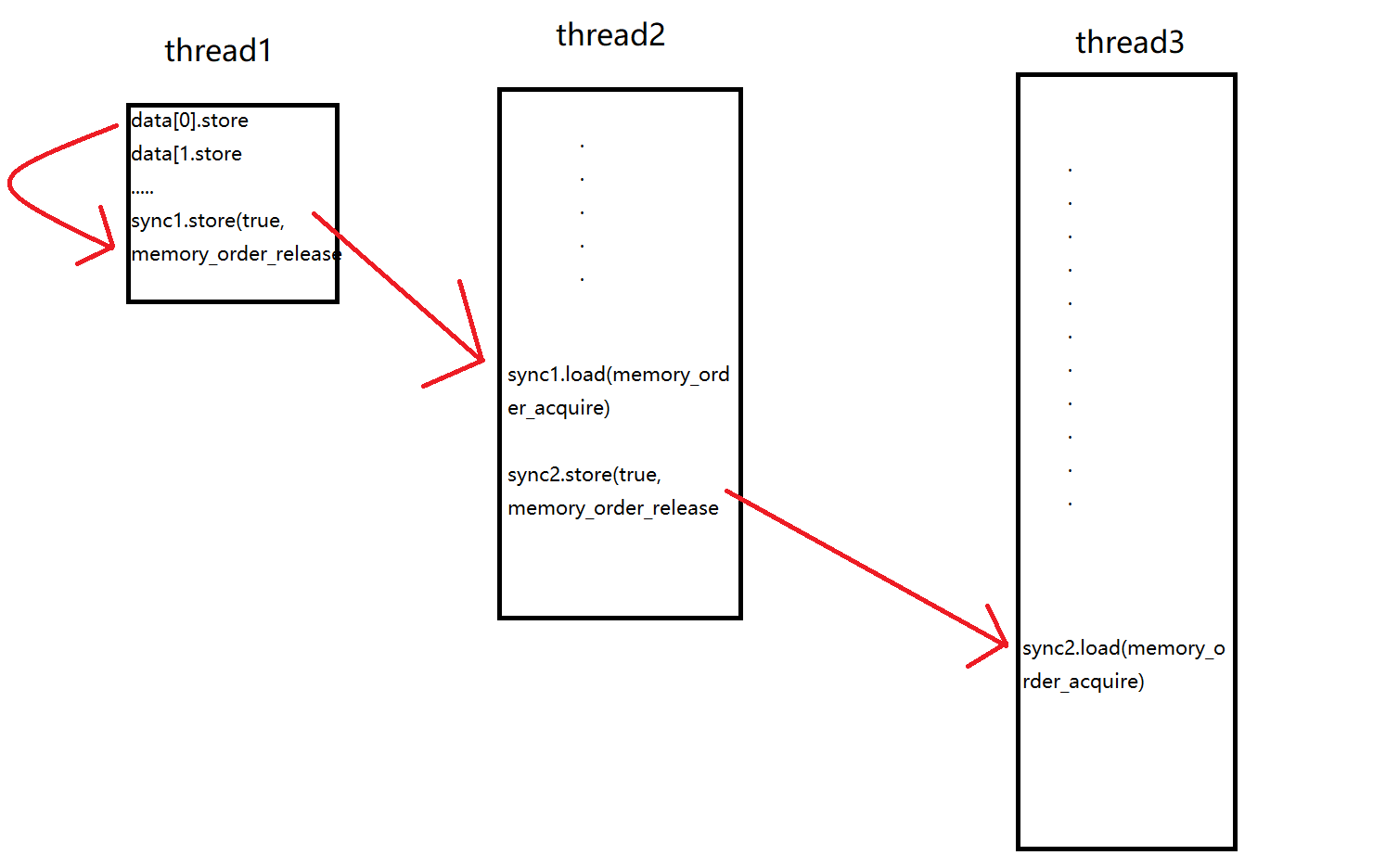

同步的传递性和acquire搭配release的小例子

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

atomic<int> data[5];

atomic<bool> sync1(false), sync2(false);

void thread_1_func(){

data[0].store(1, memory_order_relaxed);

data[1].store(2, memory_order_relaxed);

data[2].store(3, memory_order_relaxed);

data[3].store(4, memory_order_relaxed);

data[4].store(5, memory_order_relaxed);

sync1.store(true, memory_order_release); //注释1

}

void thread_2_func(){

while(!sync1.load(memory_order_acquire)); //注释2

sync2.store(true, memory_order_release); //注释3

}

void thread_3_func(){

while(!sync2.load(memory_order_acquire)); //注释4

assert(data[0].load(memory_order_relaxed) == 1);

assert(data[1].load(memory_order_relaxed) == 2);

assert(data[2].load(memory_order_relaxed) == 3);

assert(data[3].load(memory_order_relaxed) == 4);

assert(data[4].load(memory_order_relaxed) == 5);

cout << "all success" << endl;

}

int main(){

thread th1(thread_1_func);

thread th2(thread_2_func);

thread th3(thread_3_func);

th1.join();

th2.join();

th3.join();

return 0;

}

- 在

func1当中,我们的数据存储使用了relaxed,所以可能是乱序,但是无关紧要。我们的核心目的是保证thread3能看到thread1中存储的全部数据。所以: - 在

func1中,我们针对sync1的写入使用了release。也就是说,在把sync1修改为true的这个操作之前,可以保证前面的操作全部完成,不会重排到这个操作之后,同时也保证缓存一致性,也就是之前的操作全部对其他线程可见。 - 在

func2中,我们针对sync1的读取使用了acquire操作。也就是说,在读取到sync1是true之前,任何操作不能被重排到该操作之前。也就保证了针对sync2的修改一定发生在发现sync1是true之后。 - 随后在

func2中,我们针对sync3的写入使用了release。原因同上。 - 在

func3中,针对sync3的读取使用了acquire,原因同上。 - 最后在

assert中,乱序可能发生,但是无所谓。

acquire和release的语义可以形象理解为:如果我不释放(release),你的请求(acquire)必须等待,直到我释放为止。

atomic_thread_fence分类和效果

在C++ 11及之后的标准里,除了利用原子操作指定内存序,还定义了单独使用memory fence(std::atomic_thread_fence)的方式,fence可以和原子操作组合进行同步,也可以fence之间进行同步,fence不光可以不依赖原子操作进行同步,而且相比较于同样memory order的原子操作,具有更强的内存同步效果

和atomic变量类似,atomic_thread_fence也可以指定六种内存序,指定不同内存序的fence可以分为以下几类: (1) std::atomic_thread_fence(memory_order_relaxed),没有任何效果。 (2) std::atomic_thread_fence(memory_order_acquire) 和 std::atomic_thread_fence(memory_order_consume) 属于acquire fence。 (3)std::atomic_thread_fence(memory_order_release)属于release fence。 (4)std::atomic_thread_fence(memory_order_acq_rel)既是acquire fence 也是release fence,为了方便这里称为full fence。 (5)std::atomic_thread_fence(memory_order_seq_cst)额外保证有单独全序的full fence。

也就是说,如果不考虑单独全序,那么有release fence、acquire fence 和full fence三种。下面就根据以前介绍过的四种重排来介绍下这三种fence的效果。

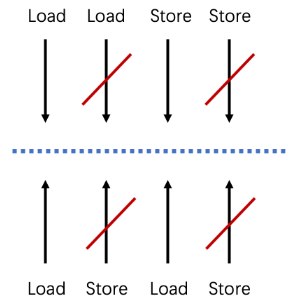

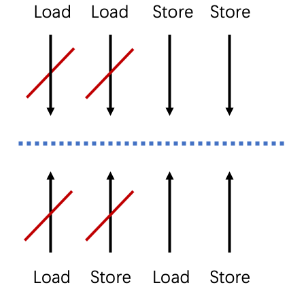

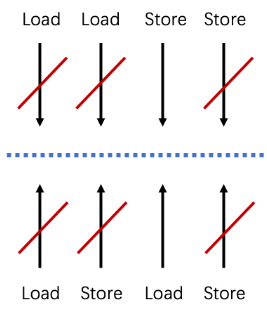

不同类型的Fence对于乱序的保护是不一样的。我们可以将读和写的交错分成下面四种情况:

- Load-Load:读接着读

- Load-Store:先读后写

- Store-Load:先写后读

- Store-Store:写接着写

release fence

Release fence可以防止fence前的内存操作重排到fence后的任意store(写入)之后,即阻止load-store重排和store-store重排。(阻止了所有在它之前的读写操作和在它之后的写操作乱序)

acquire fence

acquire fence可以防止fence后的内存操作重排到fence前的任意load(读取)之前,即阻止load-load重排和load-store重排。(阻止了所有在它之前的读操作与在它之后的读写操作乱序。)

full fence

- 因为

full fence是release fence和acquire fence的组合,所以也就是防止load-load、load-store、store-store重排

C++标准中,三种fence不禁止store-load(先写后读)的重排。

即便是std::atomic_thread_fence(memory_order_seq_cst)也一样,只是需要额外保证单独全序,但是在实际的实现上为了实现这个全序编译器大都是采用了硬件层面的能够阻止storeload重排的full barrier指令

参考资料:

https://paul.pub/cpp-memory-model/

https://blog.csdn.net/wxj1992/article/details/103917093

https://luyuhuang.tech/2022/06/25/cpp-memory-order.html

https://zhuanlan.zhihu.com/p/682286231

来自百度的介绍内存访问,分配,MESI,内存序优化的简短文章

memory barrier 和 memory fence的细微区别

chatGPT的回答:

在C++11标准中,memory fence和memory barrier是等价的概念,它们都用于确保多线程环境下的内存可见性和顺序性。

在C++11之前,memory fence通常是指硬件级别的操作,而memory barrier则是指编译器级别的操作,但是这种区分在C++11之后已经不再重要。

在C++11中,memory fence和memory barrier都有两种类型:acquire和release。acquire fence/barrier用于确保之前的读操作在当前之后的操作之前执行,release fence/barrier用于确保之后的写操作在当前之前的操作之后执行。

区别在于,memory fence是一种完全的内存屏障,它会禁止编译器和CPU对内存操作的任何优化,强制所有线程按照特定的顺序执行内存操作。而memory barrier只是一种编译器屏障,它只能保证编译器不会对内存操作进行优化,但不能保证CPU不进行优化,因此在某些平台上可能不够稳定。所以memory barrier又称为 compiler barrier

此外,memory fence和memory barrier的使用需要根据具体的情况来确定。通常,只有在需要非常精细的内存控制时才需要使用memory fence和memory barrier,因为它们会影响程序的性能。在一般情况下,可以通过使用std::atomic类型来实现线程安全的操作,它会自动处理内存屏障和同步操作。

NULL和nullptr区别

其实NULL根据命名全大写可以看出来,它是一个常量,既然是常量,就需要进行宏定义。

- C语言的标准头文件是这样定义的

#define NULL ((void*)0) - 而到了C++中,则变成了

#define NULL 0

从定义中可以看出,C++中,NULL其实就是0,但是也可以用作空指针,只是用作空指针可能是为了兼容C,迫于无奈。

但是当NULL既可以表示0又可以表示空指针的时候,发生函数重载的时候就会有二义性

1

2

3

4

5

6

7

8

9

10

11

12

13

void test(void *p)

{

cout<<"p is pointer "<<p<<endl;

}

void test(int num)

{

cout<<"num is int "<<num<<endl;

}

int main(void)

{

test(NULL); //NULL是int还是指针?

return 0;

}

很明显,NULL存在二义性,它既是整数,也是一个指针,函数test()无法根据参数的数据类型判断应该调用哪一个实现。 这时使用nullptr的优越性就体现出来了,因为它可以很好地把空指针这一层意思给剥离出来。nullptr就是C++11为了解决这个痛点而推出的东西。

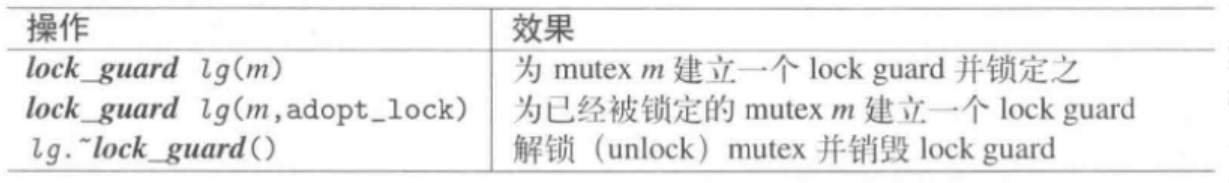

lockguard和uniquelock

注意一下锁的含义。为什么锁叫互斥量?不要认为锁和资源是挨着的。或者是资源一定和锁连着。

锁,互斥量是独立的。什么意思?假设我们有规定:想要打开抽屉,必须从桌子上拿走令牌。如果没有令牌则不能打开抽屉。所以说资源(抽屉)和锁(互斥量)不一定在一起。资源在抽屉里,锁在桌子上。两者是分离的。我只要确保每个人都可以访问到令牌(锁)和抽屉(资源)即可。

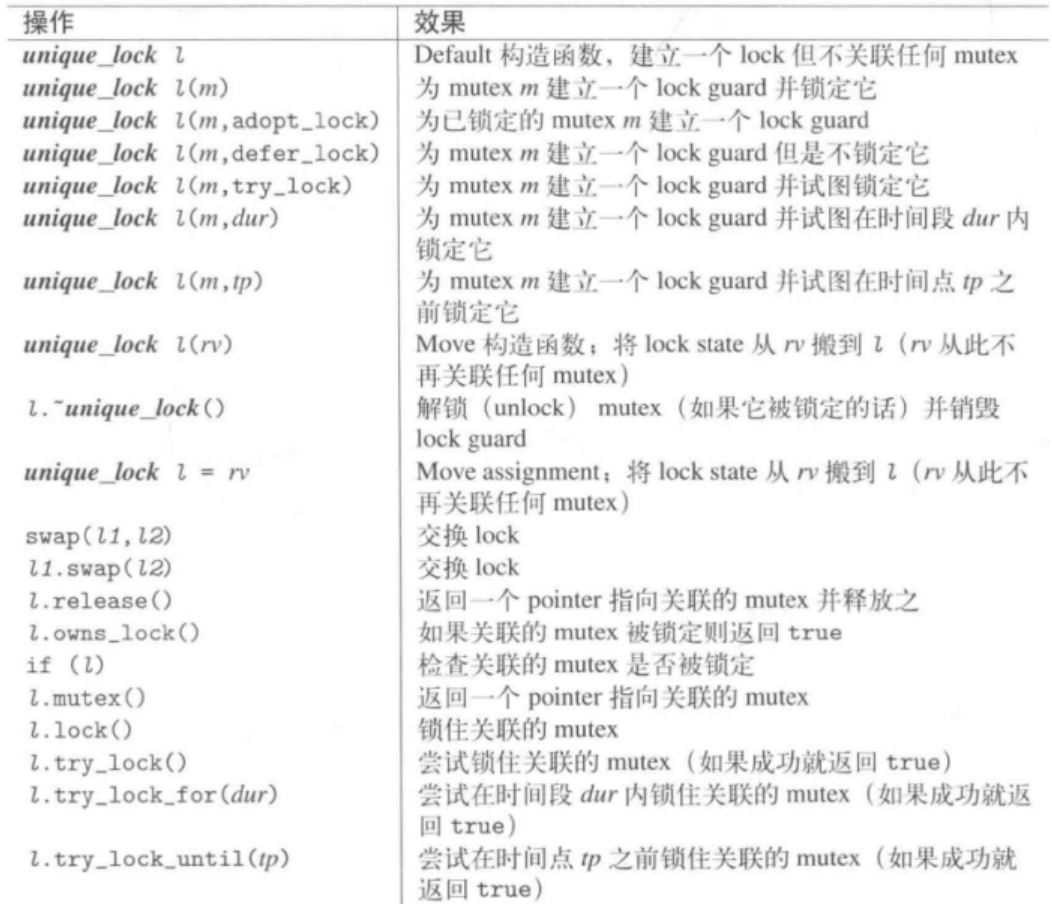

unique_lock功能丰富灵活得多。如果需要实现更复杂的锁策略可以用unique_lock- 如果只需要基本的锁功能,优先使用更严格高效的

lock_guard。 - 注意区分

mutex和lock_guard/unique_lock。后者是前者的RAII包装器。所以如果要锁的话必须这样

1

2